Альтернативы Portia для извлечения веб-данных

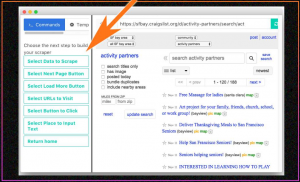

Опубликовано: 2019-07-15Portia был визуальным инструментом, который позволял пользователям сканировать веб-сайты без каких-либо знаний в области программирования. Это был размещенный сервис, но из-за сокращения использования визуальных парсеров он был отключен и сегодня больше не используется. Так как же люди использовали Порцию, когда она существовала? Чтобы использовать Portia, вам нужно будет ввести шаблон URL-адресов, которые необходимо посетить, а затем выбрать элементы на этих веб-страницах с помощью жестов «укажи и щелкни» или с помощью CSS или XPath. Несмотря на простоту использования, самыми большими проблемами с Portia были следующие:

- Это был трудоемкий инструмент, чтобы получить контроль над ним по сравнению с другими инструментами веб-скрейпинга с открытым исходным кодом.

- Навигация по сайтам была сложной.

- Вам нужно было упомянуть целевые страницы, когда вы начали сканирование, чтобы Порция не посещала ненужные URL-адреса.

- Не было никакого способа подключить базу данных, чтобы сохранить ваши очищенные точки данных.

Каковы преимущества визуальных парсеров?

Если у вас есть однократная потребность в очистке веб-страниц, вы можете использовать визуальный веб-скребок, но не рекомендуется использовать его как часть бизнес-процесса. Если вы ведете бизнес, в котором вам нужно сканировать данные с очень небольшого количества статических веб-страниц, и это происходит очень редко (скажем, раз в месяц), вы можете найти кого-то в своей команде, кто знает, какие данные нужно сканировать, чтобы понять работу визуального веб-скребка в течение нескольких часов, а затем время от времени извлечение веб-данных. Визуальные поисковые роботы особенно полезны для малых предприятий, которым не хватает технической команды и у которых есть минимальные требования к парсингу.

Визуальный веб-краулер — это почти то же самое, что кто-то нажимает «проверить элементы» на веб-странице и копирует данные из HTML-контента. Вместо этого, когда вы используете визуальный парсер, вы в конечном итоге нажимаете на часть веб-страницы, и программное обеспечение копирует данные для вас в выбранное вами место.

В каких областях визуальные парсеры терпят неудачу?

Визуальные скребки, однако, терпят неудачу, когда у вас есть серьезная тяжелая работа.

Возможно, вам потребуется включить очистку некоторых данных в рабочий процесс (это должно быть автоматизировано).

Данные могут нуждаться в очистке сотен или тысяч страниц и могут нуждаться в очень частом обновлении.

Может возникнуть необходимость в прямой передаче очищенных данных для определенного бизнес-модуля. В большинстве вышеперечисленных случаев веб-парсер на основе кода будет гораздо удобнее, чем визуальный парсер.

Большинство проектов массового парсинга обнаруживают необходимость сканирования тонны похожих веб-страниц для извлечения данных из Интернета о различных элементах. Эти элементы могут варьироваться от информации о рейсах на веб-сайтах электронного бронирования до сведений о продуктах на веб-сайтах электронной коммерции. Логика, применяемая в таких сценариях, заключается в том, что вы пытаетесь понять шаблон, в котором данные хранятся на веб-страницах, используя несколько веб-страниц, и используете код, который может не только сканировать страницы с точно такой же структурой, но даже страницы с похожей структурой. . Кроме того, при очистке всех страниц, доступных на веб-сайте, может потребоваться игнорировать страницы с определенной структурой. Все эти настройки невозможны в визуальном парсере, поэтому не рекомендуется парсить слишком много страниц с помощью визуального парсера.

С другой стороны, из-за того, что внешний вид веб-сайтов меняется каждые несколько недель или месяцев, вам может потребоваться обучать визуальный парсер каждый раз, когда меняется пользовательский интерфейс веб-сайта. С другой стороны, при использовании парсера на основе кода часто изменение пользовательского интерфейса может даже не потребовать каких-либо изменений в парсере, поскольку структура веб-сайта может остаться прежней. Даже если есть какие-то изменения в пользовательском интерфейсе, которые могут потребовать изменения парсера, изменения обычно минимальны, и настроить парсер на изменения достаточно просто.

Какие еще у нас есть альтернативы?

Существует множество альтернатив Portia. Такие языки, как Python, R и Golang, используются разработчиками и командами веб-парсинга по всему миру для извлечения веб-данных с веб-страниц. Разрабатываются новые способы ускорить этот процесс. Например, с помощью параллельного программирования и кэширования в Golang, используя пакет под названием Colly, вы можете использовать пользовательские настройки, подобные следующим:

- Количество страниц, которые вы хотите сканировать одновременно в любой момент времени.

- Максимальная глубина, на которую должен пройти парсер, когда он начинает очищать веб-страницу. (Это означает, что если вы установите максимальную глубину 3, он будет сканировать верхнюю страницу, переходить по найденному на ней URL-адресу, сканировать его, затем переходить к URL-адресу, найденному на этой странице, и также сканировать его, но теперь на третьей странице, если он найдет URL-адрес, он не пойдет дальше).

- Вы можете установить проверку слов, присутствующих в URL-адресах — то есть, если слово присутствует в URL-адресе, веб-страница в этом URL-адресе должна быть очищена. Или вы можете установить исключения — URL-адреса с определенным словом не должны быть доступны парсеру.

Это лишь некоторые из сотен крошечных функций, которые вы получаете, когда создаете парсер самостоятельно.

Поставщики DaaS против внутренней команды?

Большинству компаний, которым не хватает технической команды или даже членов, не имеющих базового понимания какого-либо языка сценариев, следует попытаться не создавать собственную команду парсинга. Причина этого проста. Деньги, которые вы тратите на наем разработчиков, а затем заставляете их создавать и поддерживать совершенно новую систему парсинга веб-страниц для нужд вашего бизнеса, будут огромными. И, в конце концов, если вы небольшая компания, и веб-скрапинг не является топливом для вашего бизнеса (то есть ваш бизнес не сосредоточен на данных, которые вы сканируете из Интернета), то нет смысла создавать внутренняя команда.

В этом случае простым решением являются поставщики DaaS, которые принимают ваши требования и предоставляют вам данные в выбранном вами формате. Наша команда в PromptCloud гордится тем, что сократила веб-скрапинг до двухэтапного процесса для предприятий и предприятий.

Вывод

Хотя визуальные инструменты хороши для бизнес-команд, мы можем согласиться с тем, что просмотр веб-страниц — это не просто бизнес-задача. Это задача, которая должна быть эффективной, быстрой и полностью настраиваемой. Если у вас есть требования к очистке веб-страниц большого объема или вы хотите извлекать веб-данные в гораздо большем масштабе, рекомендуется использовать службы очистки веб-страниц.

Если вы не разбираетесь в программировании или ваши требования сложны, вы можете использовать полностью управляемого поставщика услуг, такого как PromptCloud, для автоматического получения чистых данных без каких-либо технических хлопот или изучения какого-либо инструмента.