So beheben Sie „Entdeckt – Derzeit nicht indiziert“ in der Google Search Console

Veröffentlicht: 2022-01-11In der Dokumentation von Google wird der Status „Erkannt – derzeit nicht indiziert“ im Indexabdeckungsbericht von Google wie folgt definiert:

Die Seite wurde von Google gefunden, aber noch nicht gecrawlt. Normalerweise wollte Google die URL crawlen, aber es wurde erwartet, dass dies die Website überlastet; Daher hat Google den Crawl neu geplant. Aus diesem Grund ist das letzte Crawling-Datum im Bericht leer.Quelle: Bericht zur Indexabdeckung von Google

Tomek Rudzki hat die häufigsten Indizierungsprobleme recherchiert, die in der Google Search Console angezeigt werden, und festgestellt, dass „Entdeckt – derzeit nicht indiziert“ eines davon ist, direkt neben:

- Doppelte Inhalte,

- Gecrawlt – derzeit nicht indexiert,

- Weiche 404er und

- Crawling-Probleme.

Das Beheben des Problems „Erkannt – derzeit nicht indiziert “ sollte Priorität haben, da es viele Seiten betreffen kann und darauf hinweist, dass einige Ihrer Seiten nicht gecrawlt und anschließend indiziert wurden.

Dieses Problem kann durch viele Faktoren verursacht werden, die, wenn sie nicht behoben werden, dazu führen können, dass einige Seiten nie den Weg in den Index von Google finden. Und wenn das der Fall ist, bringen sie Ihnen keinen organischen Traffic und keine Conversions.

Dieser Artikel gibt einen tiefen Einblick in den Abschnitt „Entdeckt – derzeit nicht indiziert“ des Indexabdeckungsberichts der Search Console und konzentriert sich auf die Analyse, warum Ihre Seiten dorthin gelangen, und wie Sie alle Probleme beheben können, die dies verursachen könnten.

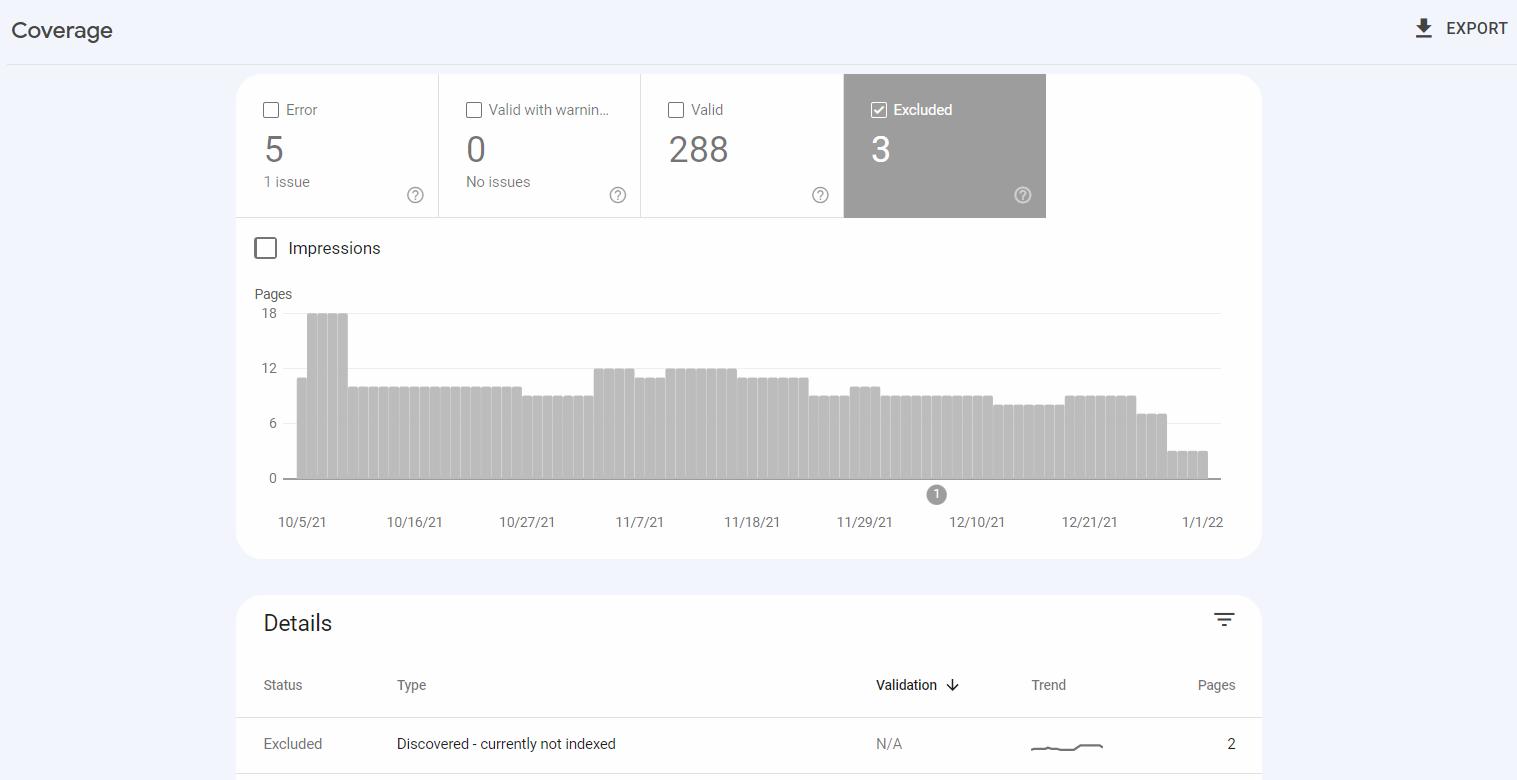

Wo finde ich den Status „Entdeckt – derzeit nicht indiziert“.

Entdeckt – derzeit nicht indexiert ist einer der Problemtypen im Bericht zur Indexabdeckung in der Google Search Console. Der Bericht zeigt den Crawling- und Indexierungsstatus der Seiten auf Ihrer Website.

Entdeckt – derzeit nicht indexiert erscheint in der Kategorie Ausgeschlossen , die URLs enthält, die Google nicht indexiert hat, aber aus Sicht von Google ist diese Situation nicht das Ergebnis eines Fehlers.

Wenn Sie die Google Search Console verwenden, können Sie auf die Art des Problems klicken, um eine Liste der betroffenen URLs anzuzeigen.

Möglicherweise stellen Sie fest, dass Sie einige der gemeldeten URLs aus dem Index heraushalten wollten – und das ist in Ordnung. Aber Sie sollten Ihre wertvollen Seiten überwachen – wenn eine von ihnen nicht indexiert wurde, überprüfen Sie, welche Probleme Google gefunden hat.

Erkennung, Crawling und Indizierung

Bevor wir zu den Merkmalen von Discovered – derzeit nicht indexiert und zur Behandlung dieses Problems übergehen, wollen wir klären, was es braucht, damit eine URL bei Google rankt:

- Google muss eine URL finden , bevor sie gecrawlt werden kann. URLs werden am häufigsten entdeckt, indem internen oder externen Links oder XML-Sitemaps gefolgt wird, die alle Seiten enthalten sollten, die indiziert werden sollen.

- Durch das Crawlen von Seiten besucht Google diese und überprüft ihren Inhalt. Google verfügt nicht über die Ressourcen, um alle gefundenen Seiten zu crawlen – und diese Tatsache steht hinter vielen Crawling-Problemen, die auf Websites auftreten.

- Bei der Indexierung extrahiert Google den Inhalt von Seiten und bewertet deren Qualität. Die Indexierung ist notwendig, um in den Suchergebnissen zu erscheinen und organischen Traffic von Google zu erhalten. Indexierte Seiten werden auf der Grundlage zahlreicher Ranking-Faktoren bewertet , die bestimmen, wie sie als Reaktion auf Suchanfragen von Nutzern in Google eingestuft werden.

Von Google indexiert zu werden, ist aufgrund der begrenzten Kapazität seiner Ressourcen, des ständig wachsenden Webs und der Tatsache, dass Google von den indexierten Seiten ein bestimmtes Qualitätsniveau erwartet, eine Herausforderung.

Viele technische und inhaltliche Faktoren können dazu beitragen, dass Ihre Seiten nicht gecrawlt oder indexiert werden.

Es gibt Lösungen, um die Chancen auf eine Indexierung zu erhöhen. Diese beinhalten:

- Eine Crawling-Strategie zu haben, die das Crawlen wertvoller Teile Ihrer Website priorisiert,

- Interne Verlinkung implementieren,

- Erstellen einer genauen Sitemap, die alle URLs enthält, die indexierbar sein sollten, und

- Hochwertige, wertvolle Inhalte schreiben.

Gehen Sie unbedingt die Dokumentation von Google durch – es gibt einen Abschnitt mit Richtlinien, die befolgt werden müssen, um es Google zu erleichtern, Ihre Seiten zu crawlen und zu indizieren.

So verwenden Sie den Berichtsabschnitt „Erkannt – derzeit nicht indiziert“.

Der Status „Entdeckt – derzeit nicht indiziert“ ist der richtige Ort, um über potenzielle Crawling-Probleme auf dem Laufenden zu bleiben.

Nachdem Sie URLs in diesem Abschnitt gefunden haben, prüfen Sie, ob sie überhaupt gecrawlt werden sollten.

Versuchen Sie gegebenenfalls , ein Muster darin zu finden, welche URLs im Bericht erscheinen . Dies hilft Ihnen zu identifizieren, welche Aspekte dieser URLs das Problem verursachen könnten.

Das Problem kann beispielsweise URLs in einer bestimmten Produktkategorie, Seiten mit Parametern oder Seiten mit einer bestimmten Struktur betreffen, wodurch sie alle als Thin Content betrachtet werden.

Wenn der Abschnitt „Entdeckt – derzeit nicht indiziert“ Maßnahmen erfordert

URLs in Erkannt – derzeit nicht indexiert erfordern nicht immer, dass Sie Änderungen an Ihrer Website vornehmen.

Sie brauchen nämlich nichts zu tun, wenn:

- Die Anzahl betroffener URLs ist gering und bleibt über die Zeit stabil, bzw

- Der Bericht enthält URLs, die nicht gecrawlt oder indexiert werden sollten, z. B. URLs mit kanonischen oder „noindex“-Tags oder URLs, deren Crawling in Ihrer robots.txt-Datei blockiert ist.

Aber es ist immer noch entscheidend, den Abschnitt dieses Berichts unter Kontrolle zu haben.

Die URLs erfordern Ihre Aufmerksamkeit, wenn ihre Anzahl zunimmt, oder sie bestehen aus wertvollen URLs, von denen Sie erwarten, dass sie einen Rang einnehmen und Ihnen erheblichen organischen Verkehr bringen.

Die Auswirkungen von Discovered – derzeit nicht indiziert auf kleinen vs. großen Websites

Die Auswirkung des Abschnitts „Entdeckt – derzeit nicht indiziert“ kann je nach Größe einer Website unterschiedlich sein.

Wenn Sie eine kleinere Website haben – die normalerweise 10.000 URLs nicht überschreitet – und Ihre Seiten qualitativ hochwertigen, einzigartigen Inhalt haben, löst sich der Status „Entdeckt – derzeit nicht indexiert“ oft von selbst auf. Google hat möglicherweise kein Problem, aber die aufgelisteten URLs wurden einfach noch nicht gecrawlt.

Kleine Websites kümmern sich im Allgemeinen nicht um Probleme mit dem Crawling-Budget , und aufgrund von Problemen mit der Inhaltsqualität oder einer schlechten internen Linkstruktur kann es zu einem Anstieg der gemeldeten Seiten kommen.

Der Status „Entdeckt – derzeit nicht indiziert“ kann für große Websites (über 10.000 URLs) besonders schwerwiegend sein und Tausende oder sogar Millionen von URLs betreffen.

Bei Onely haben wir festgestellt, dass Websites mit mehr als 100.000 URLs normalerweise unter Crawling-Problemen leiden , die häufig auf verschwendetes Crawling-Budget zurückzuführen sind.

Diese Probleme treten normalerweise auf E-Commerce-Websites auf . Sie haben oft doppelten oder dünnen Inhalt oder enthalten vergriffene oder abgelaufene Produkte. Solchen Seiten fehlt normalerweise die Qualität, die erforderlich ist, um in die Indizierungswarteschlange von Google aufgenommen zu werden, geschweige denn gecrawlt zu werden.

Beim Starten einer großen Website

Wenn Sie gerade eine große Website starten, können Sie die Arbeit des Googlebots von Anfang an erleichtern.

Wenn Sie eine große Website starten möchten, sollten Sie nicht sofort ihre gesamte Struktur starten, wenn sie viele leere oder unfertige Seiten enthält, die erst später aktualisiert werden. Der Googlebot wird auf diese Seiten stoßen und sie als minderwertig einstufen, was das Risiko birgt, von Anfang an ein niedriges Crawl-Budget zu haben. Und es kann sogar Jahre dauern, diese Situation zu beheben.

Es ist viel besser, Inhalte hinzuzufügen, wenn Sie sie regelmäßig veröffentlichen. So bekommt der Googlebot von Anfang an einen positiven Eindruck von Ihrer Qualität.

Bevor Sie starten, sollten Sie immer eine Indexierungs- und Crawling-Strategie haben und wissen, welche Seiten von Google besucht werden sollen.

Ursachen für den Status „Entdeckt“ – derzeit nicht indiziert und wie man sie behebt

Typischerweise werden URLs als entdeckt klassifiziert – derzeit aufgrund von Problemen mit der Inhaltsqualität, der internen Verlinkung oder dem Crawl-Budget nicht indexiert.

Lassen Sie uns überlegen, warum Sie Ihre Seiten möglicherweise mit diesem Status sehen und wie Sie ihn beheben können.

Probleme mit der Inhaltsqualität

Google hat Qualitätsschwellenwerte, die Seiten erfüllen sollen, da es nicht alles im Web crawlen und indizieren kann.

Google sieht möglicherweise einige Seiten Ihrer Domain als nicht wert an, gecrawlt zu werden, und überspringt sie, wobei anderen, wertvolleren Inhalten Vorrang eingeräumt wird. Infolgedessen können diese URLs als entdeckt markiert werden – derzeit nicht indexiert.

Es ist erwähnenswert, dass das Vorhandensein von URLs als „Erkannt – derzeit nicht indexiert“ oft nicht auf die markierten Seiten beschränkt ist, sondern ein Qualitätsproblem der gesamten Website sein kann, wie John Mueller sagte . Wenn Google Ihre Website im Vergleich zu anderen Inhalten im Web als qualitativ minderwertig ansieht, überspringt es möglicherweise das Crawlen und Indizieren Ihrer Seiten.

Um dieses Problem zu beheben, gehen Sie die Liste der betroffenen URLs durch und stellen Sie sicher, dass jede Seite eindeutige Inhalte enthält. Der Inhalt soll die Suchabsicht des Nutzers befriedigen und ein konkretes Problem lösen.

Ich empfehle Ihnen, die Quality Rater-Richtlinien durchzugehen , die Google bei der Bewertung von Websites befolgt – sie helfen Ihnen zu verstehen, wonach Google in Inhalten sucht, die im Web gefunden werden.

Vergessen Sie dabei nicht, dass Sie nicht alle Ihre Seiten indexieren lassen sollten.

Einige Seiten mit geringer Qualität sollten nicht indexierbar sein , z. B.:

- Veraltete Inhalte (wie alte Nachrichtenartikel),

- Seiten, die von einem Suchfeld innerhalb einer Website generiert werden,

- Seiten, die durch Anwendung von Filtern generiert wurden,

- Doppelte Inhalte,

- Automatisch generierte Inhalte,

- Nutzergenerierte Inhalte.

Blockieren Sie am besten das Crawlen und Indizieren solcher Abschnitte in Ihrer robots.txt-Datei.

Während der SEO-Sprechstunde am 31. Dezember 2021 diskutierte John Mueller über Änderungen an der Qualität einer Website, um Entdeckte – derzeit nicht indizierte – anzusprechen:

[…] Um größere Qualitätsänderungen auf einer Website vorzunehmen, dauert es ziemlich lange, bis die Google-Systeme dies erkennen. […] Das ist eher so etwas wie mehrere Monate und nicht mehrere Tage. […] Da es so lange dauert, bis Qualitätsänderungen erkannt werden, würde ich empfehlen, keine kleinen Änderungen vorzunehmen und abzuwarten, ob es gut genug ist, sondern wirklich sicherzustellen, dass, wenn Sie erhebliche Qualitätsänderungen vornehmen, […] es sind wirklich gute Qualitätsänderungen […]. Sie wollen nicht ein paar Monate warten und dann entscheiden: ‚Oh, ja, ich muss tatsächlich auch noch ein paar andere Seiten ändern.'Quelle: Johannes Müller

Probleme bei der internen Verlinkung

Der Googlebot folgt internen Links auf Ihrer Website, um andere Seiten zu entdecken und die Verbindungen zwischen ihnen zu verstehen. Stellen Sie daher sicher, dass Ihre wichtigsten Seiten häufig intern verlinkt sind.

Martin Splitt sprach im Rendering SEO Webinar darüber, warum falsche Verlinkungsstrukturen problematisch sein könnten :

[…] Wenn wir etwa tausend URLs von Ihnen haben, die alle nur in der Sitemap stehen und wir sie auf keiner der anderen von uns gecrawlten Seiten gesehen haben, könnten wir sagen: „Wir wissen nicht, wie wichtig das ist wirklich“ […]. Anstatt es nur in der Sitemap zu haben, verlinken Sie es von anderen Stellen auf Ihrer Website , damit wir beim Crawlen dieser Seiten „Aha! Also diese Seite und diese Seite und diese Seite verweisen alle auf diese Produktseite, also ist sie vielleicht ein bisschen wichtiger als dieses andere Produkt, das nur in der Sitemap lebt' […].Quelle: Martin Splitt

Die richtige interne Verlinkung dreht sich darum, Ihre Seiten zu verbinden, um eine logische Struktur zu erstellen, die Suchmaschinen und Benutzern hilft, der Hierarchie Ihrer Website zu folgen. Die interne Verlinkung hängt auch damit zusammen, wie Ihre Site-Architektur aufgebaut ist.

Suchmaschinen dabei zu helfen, Ihre Seiten zu finden und ihnen die angemessene Bedeutung zuzuweisen, umfasst:

- Entscheiden Sie, was Ihr Cornerstone-Content ist, und stellen Sie sicher, dass er von anderen Seiten verlinkt wird,

- Hinzufügen kontextbezogener Links in Ihren Inhalten,

- Verknüpfen von Seiten basierend auf ihrer Hierarchie, z. B. durch Verknüpfen von übergeordneten Seiten mit untergeordneten Seiten und umgekehrt, oder Einfügen von Links in die Navigation der Site,

- Vermeidung von Spam-Platzierung von Links und Überoptimierung von Ankertexten,

- Integrieren von Links zu verwandten Produkten oder Beiträgen.

Lesen Sie auch diesen Artikel zur Verbesserung der internen Linkstruktur.

Crawl-Budget

Das Crawl-Budget ist die Anzahl der Seiten, die der Googlebot auf einer Website crawlen kann und will.

Das Crawling-Budget einer Website wird bestimmt durch:

- Crawl-Rate-Limit – wie viele URLs Google crawlen kann, die an die Fähigkeiten Ihrer Website angepasst werden,

- Crawling-Nachfrage – wie viele URLs Google crawlen möchte, basierend darauf, wie wichtig die URLs sind, indem es ihre Popularität betrachtet und wie oft sie aktualisiert werden.

Die Verschwendung des Crawl-Budgets kann zu einem ineffizienten Crawling Ihrer Website durch Suchmaschinen führen . Infolgedessen können einige grundlegende Teile Ihrer Website übersprungen werden.

Viele Faktoren können Probleme mit dem Crawl-Budget verursachen – dazu gehören:

- Inhalte von geringer Qualität,

- Schlechte interne Verlinkungsstruktur,

- Fehler bei der Implementierung von Weiterleitungen,

- Überlastete Server,

- Schwere Websites.

Bevor Sie Ihr Crawling-Budget optimieren, sollten Sie genau prüfen, wie der Googlebot Ihre Website crawlt.

Sie können dies tun, indem Sie zu einem anderen hilfreichen Tool in der Search Console navigieren – dem Crawl-Statistikbericht. Überprüfen Sie auch Ihre Serverprotokolle auf detaillierte Informationen darüber, welche Ressourcen der Googlebot gecrawlt und welche er übersprungen hat.

Im Folgenden sind 5 Aspekte aufgeführt, die Sie berücksichtigen sollten, um Ihr Crawl-Budget zu optimieren und Google dazu zu bringen, einige der entdeckten – derzeit nicht indizierten Seiten auf Ihrer Website zu crawlen:

Inhalte von geringer Qualität

Wenn der Googlebot Seiten mit geringer Qualität problemlos crawlen kann, verfügt er möglicherweise nicht über die Ressourcen, um an die wertvollen Inhalte auf Ihrer Website zu gelangen.

Um zu verhindern, dass Suchmaschinen-Crawler bestimmte Seiten crawlen, wenden Sie die richtigen Anweisungen in der robots.txt-Datei an.

Sie sollten auch sicherstellen, dass Ihre Website über eine korrekt optimierte Sitemap verfügt, die dem Googlebot hilft, eindeutige, indexierbare Seiten auf Ihrer Website zu entdecken und Änderungen darauf zu erkennen.

Die Sitemap sollte enthalten:

- URLs antworten mit 200 Statuscodes,

- URLs ohne Meta-Roboter-Tags, die ihre Indexierung blockieren, und

- Nur die kanonischen Versionen Ihrer Seiten.

Schlechte interne Linkstruktur

Wenn Google nicht genügend Links findet, die zu einer URL führen, überspringt es möglicherweise das Crawlen, da unzureichende Signale auf ihre Wichtigkeit hinweisen.

Befolgen Sie meine Richtlinien, die im Unterkapitel „Interne Verlinkungsprobleme“ beschrieben sind.

Fehler bei der Implementierung von Weiterleitungen

Das Implementieren von Weiterleitungen kann für Ihre Website von Vorteil sein – aber nur, wenn es richtig gemacht wird. Wenn der Googlebot auf eine umgeleitete URL trifft, muss er eine zusätzliche Anfrage senden, um zur Ziel-URL zu gelangen, was mehr Ressourcen erfordert.

Stellen Sie sicher, dass Sie sich an Best Practices für die Implementierung von Weiterleitungen halten. Sie können sowohl Benutzer als auch Bots von 404-Fehlerseiten, die von externen Quellen verlinkt wurden, auf Arbeitsseiten umleiten, was Ihnen hilft, Ranking-Signale zu erhalten.

Stellen Sie jedoch sicher, dass Sie nicht auf umgeleitete Seiten verlinken – aktualisieren Sie sie stattdessen so, dass sie auf die richtigen Seiten verweisen. Sie müssen auch Umleitungsschleifen und -ketten vermeiden.

Serverprobleme

Bei Google könnten Crawling-Probleme auftreten, da Ihre Website anscheinend überlastet ist. Dies liegt daran, dass die Crawling-Rate, die sich auf das Crawling-Budget auswirkt, an Ihre Serverkapazitäten angepasst wird.

In einem Webinar zum Thema Rendering SEO diskutierte Martin Splitt Serverprobleme in Bezug auf das Crawlen von Seiten durch Google:

[…] Eine Sache, die ich oft sehe, ist, dass Server intermittierende Fehler ausgeben – insbesondere 500-etwas – und alles, worauf Ihr Server mit 500, 501, 502, 504 oder was auch immer antwortet, bedeutet, dass Ihr Server sagt: „Warte ‚Ich habe hier ein Problem‘ […], und es könnte jeden Moment umfallen, also ziehen wir uns zurück. Wann immer wir uns zurückziehen und Ihr Server positiv antwortet, fahren wir normalerweise langsam wieder hoch. Stellen Sie sich vor, Sie hätten jeden Tag etwa 500 Antworten.Wir sehen das, wir bremsen ein wenig ab, wir fahren wieder hoch – wir sehen es wieder […]. Sie sollten prüfen, ob Ihr Server negativ reagiert.

Quelle: Martin Splitt

Erkundigen Sie sich bei Ihrem Hosting-Provider, ob es Serverprobleme auf Ihrer Website gibt.

Serverprobleme können auch durch schlechte Webleistung verursacht werden – erfahren Sie mehr in unserem Artikel über Webleistung und Crawl-Budget.

Schwere Websites

Crawling-Probleme können dadurch verursacht werden, dass einige Seiten zu umfangreich sind. Google hat möglicherweise einfach nicht genügend Ressourcen, um sie zu crawlen und zu rendern.

Jede Ressource, die der Googlebot zum Rendern Ihrer Seite abrufen muss, wird Ihrem Crawl-Budget angerechnet. In diesem Fall sieht Google eine Seite, schiebt sie aber weiter in die Prioritätswarteschlange.

Sie sollten die JavaScript- und CSS-Dateien Ihrer Website optimieren, um die negativen Auswirkungen Ihres Codes zu reduzieren.

Eine neue Website haben

Tomek Rudzki erstellte eine Twitter-Umfrage, in der er die SEO-Community zu Indexierungsproblemen auf neuen Websites befragte. Und den Umfrageergebnissen zufolge hatten fast 40 % der Menschen solche Probleme:

Haben Sie LETZT Probleme mit der Indizierung der neuen Websites?

– Tomek Rudzki (@TomekRudzki) 7. Dezember 2021

Während einer der SEO Office Hours-Sitzungen brachte ein Teilnehmer seine neue Website zur Sprache, die vor 2 Monaten gestartet wurde, auf der viele Seiten als entdeckt markiert waren – derzeit nicht indiziert. Dann fragte er, wie lange Seiten mit diesem Status voraussichtlich erscheinen würden, worauf John antwortete:

Das kann ewig dauern […]. Und gerade bei einer neueren Website, wenn Sie viele Inhalte haben, dann würde ich davon ausgehen, dass viele der neuen Inhalte für eine Weile entdeckt und nicht indexiert werden. Und dann verschiebt es sich normalerweise mit der Zeit. Und es ist wie, nun, es wird tatsächlich gecrawlt oder es wird tatsächlich indiziert, wenn wir sehen, dass es tatsächlich sinnvoll ist, sich mehr auf die Website selbst zu konzentrieren.Quelle: Johannes Müller

Normalerweise gibt es keine schnellen Lösungen, um die Seiten indizieren zu lassen, aber ein Blick auf die SEO-Aspekte, die ich zuvor beschrieben habe, kann Ihnen helfen, eine bessere Chance zu haben, sie indizieren zu lassen.

Es ist klar, dass Google sicher sein möchte, dass es nur qualitativ hochwertige Inhalte indiziert, und diese Qualitätsschwellen scheinen zu steigen. Besonders herausfordernd ist dies jedoch für neue Websites, die Google immer wieder beweisen müssen, dass ihre Inhalte es verdienen, in den Index aufgenommen zu werden.

Weitere Informationen zur Adressierung von Discovered – derzeit nicht indiziert

Während der SEO Office Hours wurde John Mueller nach der Lösung des Problems gefragt, bei dem etwa 99 % der URLs auf einer Website im Abschnitt „Entdeckt – derzeit nicht indiziert“ hängen bleiben.

Johns Empfehlungen drehten sich um drei Hauptschritte:

[…] Ich würde vielleicht erst einmal schauen […] dass du nicht versehentlich URLs mit unterschiedlichen URL-Mustern generierst, […] Dinge wie die Parameter, die du in deiner URL hast, Groß-Kleinschreibung, all diese Dinge können dazu führen Inhalte im Wesentlichen zu duplizieren . Und wenn wir viele dieser doppelten URLs entdeckt haben, denken wir vielleicht, dass wir nicht alle diese Duplikate crawlen müssen, weil wir bereits eine Variation dieser Seite darin haben […]. Stellen Sie sicher, dass anhand der internen Verlinkung alles in Ordnung ist. Dass wir alle diese Seiten auf Ihrer Website durchsuchen und bis zum Ende schaffen könnten. Sie können dies grob testen, indem Sie ein Crawler-Tool oder etwas wie Screaming Frog oder Deep Crawl verwenden . […] Sie werden Ihnen im Wesentlichen mitteilen, ob sie zu Ihrer Website durchkriechen können, und Ihnen die URLs zeigen, die während dieses Crawlings gefunden wurden. Wenn das Crawling funktioniert, würde ich mich stark auf die Qualität dieser Seiten konzentrieren . Wenn Sie von 20 Millionen Seiten sprechen und 99 % davon nicht indexiert werden, indexieren wir nur einen wirklich kleinen Teil Ihrer Website. […] Vielleicht ist es sinnvoll zu sagen: „Nun, was ist, wenn ich die Seitenzahl halbiere oder vielleicht sogar […] auf 10 % der aktuellen Zahl reduziere“. […] Sie können die Qualität der dortigen Inhalte generell etwas verbessern, indem Sie auf diesen Seiten umfangreichere Inhalte haben. Und für unsere Systeme ist es ein bisschen einfacher, sich diese Seiten anzusehen und zu sagen: „Nun, diese Seiten […] sehen eigentlich ziemlich gut aus. Wir sollten losgehen und viel mehr crawlen und indizieren.Quelle: Johannes Müller

In einer weiteren Office-Hours-Sitzung am 18. Februar 2022 wurde John erneut zu einer großen Anzahl von URLs befragt, die anscheinend als „Entdeckt – derzeit nicht indexiert“ hängen bleiben.

Und John hat gesagt, dass es oft normal ist, viele Seiten mit diesem Status zu haben:

[…] Bis zu einem gewissen Grad würde ich einfach akzeptieren, dass Google nicht alles crawlen und indexieren kann. […] Wenn Sie beispielsweise feststellen, dass […] einzelne Produkte nicht gecrawlt und indexiert werden, stellen Sie sicher, dass zumindest die Kategorieseite für diese Produkte gecrawlt und indexiert wird. Denn auf diese Weise können die Leute immer noch einige Inhalte für diese einzelnen Produkte auf Ihrer Website finden […].Quelle: Johannes Müller

Mitglieder der SEO-Community berichten von einer erhöhten Anzahl von Seiten, die als entdeckt markiert wurden – derzeit seit Monaten nicht indiziert. Einige testen alternative Lösungen, um dieses Problem anzugehen.

Dan Shure beschloss, es zu testen, indem er hängengebliebene Inhalte auf verschiedene URLs verschob, was dazu führte, dass sie tatsächlich indexiert wurden.

Es scheint also möglich, dass viele dieser Seiten einfach hängen bleiben, nachdem sie zunächst in diesem Status belassen wurden.

Entdeckt – derzeit nicht indiziert vs. gecrawlt – derzeit nicht indiziert

Diese beiden Status werden häufig verwechselt und bedeuten, obwohl sie miteinander verbunden sind, unterschiedliche Dinge.

In beiden Fällen wurden die URLs nicht indexiert, aber bei Crawled – derzeit nicht indexiert hat Google die Seite bereits besucht . Bei Erkannt – aktuell nicht indexiert wurde die Seite von Google zwar gefunden, aber nicht gecrawlt.

Gecrawlt – derzeit indiziert wird oft durch eine Verzögerung bei der Indizierung, Probleme mit der Inhaltsqualität, Probleme mit der Site-Architektur oder eine möglicherweise deindexierte Seite verursacht.

Wir haben auch einen ausführlichen Artikel, der erklärt, wie man Crawled behebt – derzeit nicht indiziert.

Einpacken

Entdeckt – derzeit nicht indiziert, wird in der Regel durch Probleme mit der Seitenqualität und dem Crawl-Budget verursacht.

Um diese Probleme zu beheben – und Google dabei zu helfen, Ihre Seiten in Zukunft effizient und genau zu crawlen – müssen Sie möglicherweise viele Aspekte Ihrer Seiten durchgehen und sie optimieren.

Hier sind einige wichtige Dinge, die helfen können, Probleme mit entdeckten – derzeit nicht indizierten Seiten zu vermeiden:

- Verwenden Sie die robots.txt-Datei, um den Googlebot daran zu hindern, Seiten mit geringer Qualität zu crawlen und sich auf doppelte Inhalte zu konzentrieren, z. B. Seiten, die von Filtern oder Suchfeldern auf Ihrer Website generiert wurden.

- Nehmen Sie sich Zeit, um eine richtige Sitemap zu erstellen, die Google verwenden kann, um Ihre Seiten zu entdecken.

- Halten Sie Ihre Website-Architektur intakt und stellen Sie sicher, dass Ihre wichtigen Seiten intern verlinkt sind.

- Setzen Sie eine Indexierungsstrategie ein, um die Seiten zu priorisieren, die für Sie am wertvollsten sind.

- Optimieren Sie unter Berücksichtigung des Crawl-Budgets.