GPT-3 書寫工具的工作原理以及使用時要注意的 4 件事

已發表: 2022-10-24自 GPT-3 出現以來,有大量初創公司在爭奪以各種格式銷售 AI 文案服務的用戶的關注。

電子郵件、博客文章、登陸頁面、廣告文案、銷售溝通......

還記得大多數翻譯和校對工作仍然由人類完成的時候嗎?

然後是 DeepL、谷歌翻譯和語法。

使每個人的識字和語言民主化和加速。

你猜怎麼著?

那裡發生的事情現在正在發生在文本創建中。

整個價值鏈的源頭層。

讓我們討論一下 AI 文案正在發生什麼,為什麼 GPT-3 只是一個開始,以及這些 AI 文案工具中的大多數除了在同一核心之上構建一些漂亮的面孔之外,並沒有做太多事情。

Jarvis、Copy AI、CopySmith、CopyShark、Writesonic、Anyword...

他們來了,看到了 GPT-3,現在正試圖贏得你作為潛在用戶。

一些人工智能文案工具發展得非常快,建立了強大的收入渠道,並從優秀的投資者那裡籌集資金。

經常過度承諾數百個模板並沒有真正提供他們所說的那樣,當歸結起來時,它們都沒有影響和改進其核心文本質量的能力。

他們都依賴於...

來自 OpenAI 的 GPT-3。

有很多能力,一個真正的通用人工智能強國和許多好奇的頭腦的燈塔,他們現在湧向自然語言生成領域。

但 GPT-3 只是一個令人難以置信的快速發展的技術分支的開始。

突然出現了 GPT-3,危險變成了機會。 OpenAI 的歷史

和我一起做一個簡短的技術介紹。 讓我告訴你更多關於那些看似神秘的信件的含義。

GPT-3代表Generative Pre-trained Transformer v3 。

讓我逐字逐句地引導你。

從簡單的“生成”開始意味著人工智能模型旨在創造。

對於“變形金剛”,我們不是在談論我們從電影中知道的 3 層樓大小的汽車人。

Transformer 是深度學習和人工智能領域相對較新的發展。

一種技術,使機器能夠學習人類語言的模式並通過逐字創建句子來繼續學習。

單獨的變壓器模型就像一個新生兒,除非它向父母學習,否則它無法做很多事情。

變形金剛通過閱讀數十億個示例來學習以發揮創造力。

這就是為什麼它被稱為對大量人類語言進行“預訓練”的原因。

我們談論數以萬億計的單詞。

我也會在這里和那裡談論模型。

我們在這裡不做高級時裝,因此,嘗試將模型視為某物的快照。

包括它所經歷的所有經驗、學習和發展。

想想你今天早上是如何醒來的,這一刻反映並包括了你的整個生活,充滿了經驗和學習,這使你成為了今天的你。

想像一下,您用所有先前影響的事件拍攝這一刻的快照。 這是一個根據您的經驗預先訓練的模型。

讓我知道這是否讓您在評論或 DM 中更容易理解 GPT-3 模型。

我們是 TextCortex 一家 AI 初創公司,它會帶走你 80% 的寫作工作。

OpenAI 的歷史

為什麼 OpenAI 在這種情況下很重要?

他們是能夠在該領域引起重大興趣的燈塔。

從好奇的學者、嚴肅的公司、富有創造力的企業家一直到單身人士,他們都希望在變壓器技術創造歷史時成為其中的一員。

讓我們從創建 GPT-3 的人開始這個故事情節。

2015 年底- 故事始於我們今天看到的技術創新者埃隆·馬斯克 (Elon Musk) 的許多創新發展。

他們與 Sam Altman 和其他幾位投資夥伴一起承諾斥資 10 億美元建立一個非營利組織,該組織將與研究界自由合作並引領人工智能的倫理髮展。

2019年對於 OpenAI 來說是真正多事的一年。

在 Elon Musk 離開該組織後,微軟參與了另外 10 億美元的項目,將公司轉變為一個商業驅動的營利性組織。

當 OpenAI 準備上市時,他們的一個模型開始引起轟動——當時宣稱太危險而無法向世界發布。

旁注:上面提到的危險是我在大學學習機器學習時搬到太空的原因之一。

2020 年,他們向全世界發布了 GPT-3。

一個 AI 模型幾乎是其前身的116 倍( 1750 億)。 參數*.

最初,只有少數幾家選定的機構可以進行試驗,直到最近他們向所有願意為其功能支付昂貴費用的人開放 GPT-3。

- 將參數視為補充和幫助您的 AI 大腦的大小。

AI文案的出現

GPT-3 激勵了許多產品構建者在 GPT-3 之上創建一個美觀的用戶界面。 我只是在開始時提到了其中的一些。

但是,我們每週都會觀察到相同產品的新發布。

在看到第 40 個工具後,我停止將有關它們的信息收集到我的知識庫中......

我看到他們中的一些人聲稱他們通過成為更好的“GPT-3 API 的溝通者”來區分自己。

這意味著什麼? 這是一個真正的差異化點嗎?

API 是應用程序編程接口的縮寫。

聽起來很複雜,但你還記得電影中的大神諭總是有一個看門人為他們說話嗎?

API對於計算機來說就是這樣。

所有這些 AI 文案公司都在朝 GPT-3 的守門人朝聖,以發送用戶的願望並獲得答案。

回到成為 GPT-3 的看門人 API 的最佳溝通者這一點。

雖然溝通很重要,但它不會影響預言機在創建時的過程。

只有 OpenAI 才能改進為您創造的人工智能。

然而,GPT-3 不再是區塊上唯一的預言機。

隨著興趣的增加,有各種不同的 oracles 可用,在 TextCortex,我們每天都在用我們自己的數據訓練它們,以實現它們各自的最佳目標。

使用 GPT-3 編寫工具時要注意的 4 件事

正如我所說,我們已經看到那些人工智能文案工具像雨後森林地面上的蘑菇一樣突然出現。

他們中的大多數人只有一個動機——賺快錢。

當您考慮軟件背後公司的穩定性時,這就會成為一個問題。

我們做了一些估算,並以我們的高級用戶為例,他們的單個用戶每月的運營成本約為 100 美元。

我向那些開始終身交易的人表示哀悼,他們才意識到 GPT-3 並不是免費提供的。

對於購買這些產品的客戶現在站在關上的門前,使用沒有回應的軟件感到難過。

此外,像 Replika AI 這樣擁有 700 萬用戶的大型 AI 合作公司已經放棄了 GPT-3,因為它們無法影響質量,同時為了鎖定依賴關係而支付高昂的運營成本。

1. 不要跳到最便宜(終身)的交易上

就像生活中的許多東西一樣,買便宜的東西很貴。

終身交易也是如此。

我見過很多用戶聯繫我們,因為他們曾經使用的軟件要么關閉了客戶支持,要么本身不再工作,因為它存在根本的操作缺陷。

小心... 快付錢給眼睛裡有美元符號的人。

2.不要中了#模板技巧

許多廣告模板只是佔位符,以便了解您可能感興趣的內容。

這是我們觀察到的常見抱怨。 糟糕的“創建相關性說明”或不斷重複的創建模式。

我們在社區內的密切對話中積極詢問用戶他們想要什麼。

當我們對某種格式產生足夠的興趣時,我們會深入挖掘,收集數據,訓練自己的 AI 轉換器模型,並為我們的社區提供可持續發展的東西。

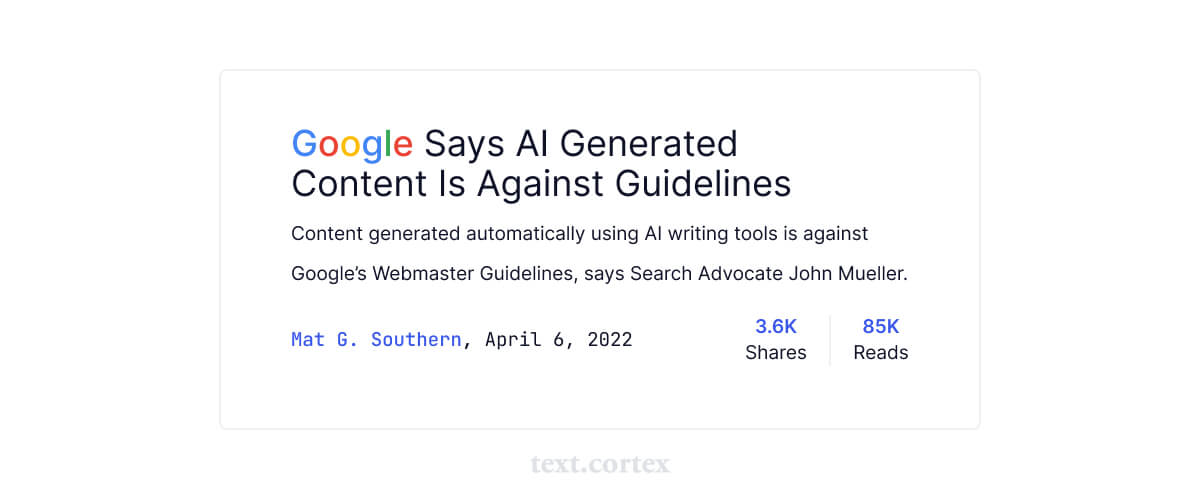

3. 當每個人都使用相同的時候,它會損害你的排名

正如我們所說,所有這些聲稱是人工智能但最終只是通過千篇一律的流程推動和旋轉您的輸入的基於規則的軟件正在受到打擊。

儘管像 GPT-3 這樣的現代人工智能技術讓人感覺非常有創意和自然,但假設檢測他們的創造將是一個挑戰,它會給你一種安全感。

但是,如果太多人使用單一模式來創建它,則可以對其進行逆向工程。

我們看到運行 GPT-3 的提供商每月為您提供 10.000 篇博客文章。

那些不良行為者只會螺旋出更多的踪跡以提出解決方案。

目前,我們認為可以利用內容相關性 (RTC) 指標來檢測 AI 生成內容的使用情況。

讓我給你一個手機市場的類似情況。

如果您要提供服務、構建應用程序或攻擊系統,您會選擇哪一個?

蘋果的 iOS 帶有 apx。 27.5%還是Androids 71%的全球移動操作系統份額?

所以想想谷歌在處理人工智能生成的內容時的第一個目標是什麼。

使用目標驅動的模型對您有利,這些模型是各自領域的專家。

在它旁邊,您應該盡可能多地尋找可定制性。 例如,我們為您提供利用不同的創意引擎。

4. 基礎設施更新時不穩定

那些大型語言模型正在不斷發展。

任何更新和培訓底層基礎設施都會影響文本質量的輸出。

由於大多數 AI 文案工具都依賴並依賴於 GPT-3 的多種變體,因此其基礎架構的更改會破壞質量。

他們需要時間才能找到“他們再次與神諭通信”。 ;)

為什麼 GPT-3 只是自然語言生成的開始,以及我們如何在 TextCortex 以不同的方式做事

我現在已經把它寵壞了好幾次了,你可以猜到我的答案,我們是否使用 GPT-3 實現了自然語言生成的 Olymp?

這是一個不,我們沒有。

毫不猶豫地,我再次重申,GPT-3 是大膽的一步,它讓個人、學者、企業和政府都加入了這個領域。

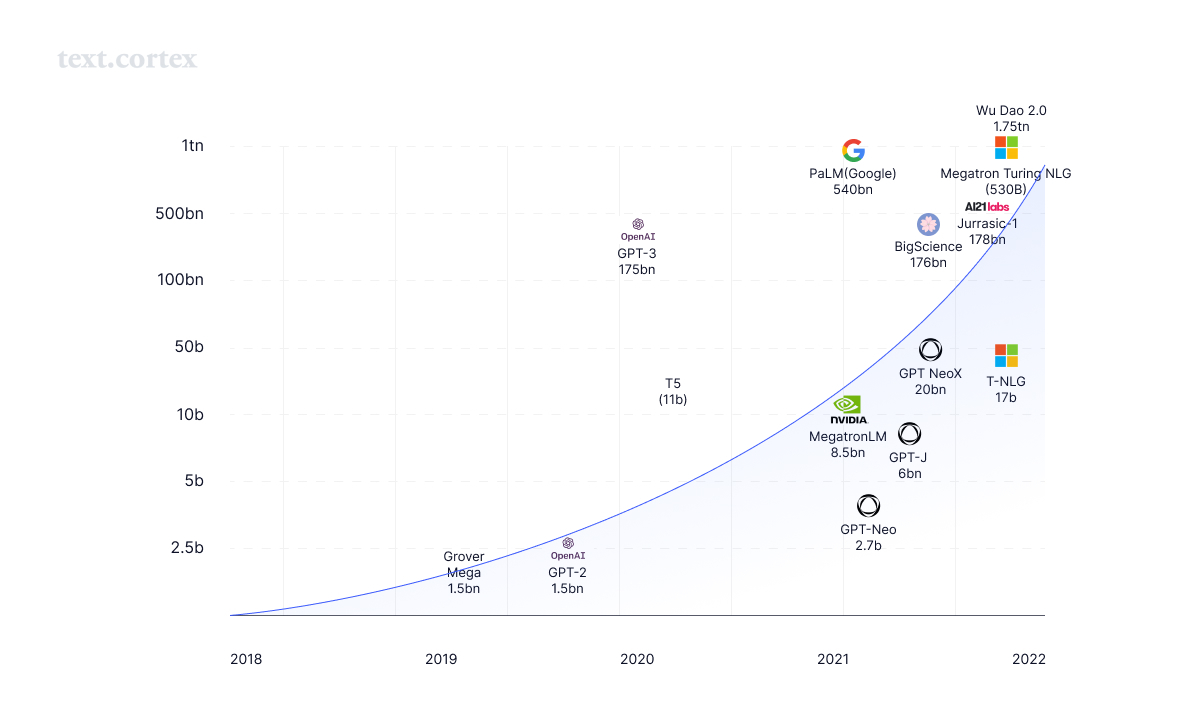

儘管如此,這是一個新時代的開始。 目前,我們看到了在創建具有更多參數、更大大腦的 AI 方面的軍備競賽。

回到我的變形金剛(電影)敘事微軟威震天圖靈模型。

大腦大小是 GPT-3 的 3 倍的模型。

使用其5300億。 為您的產品或博客文章編寫描述的參數就像為智能手機充電的唯一目的建造一座煤電廠。

它不止於此。

有傳言稱 GPT-4 將在萬億參數中。

谷歌宣布已經實現了數万億的模型。

中國武道模式也在那裡。

這是否意味著它們比 GPT-3 好 10 倍?

更大的參數大小會帶來更好的創建嗎?

強大的力量是否伴隨著巨大的責任?

有一件事是肯定的:大參數大小肯定會帶來巨大的功耗。

構建、訓練和操作如此龐大的語言模型對環境來說是一場災難。

還記得我之前是如何談論“預訓練”模型的嗎? 創建一個超出其可以學習的數量的大腦並沒有幫助。 最聰明的蹣跚學步的孩子僅限於學習從環境中觀察到的東西。

我們非常尊重從 OpenAI 到 DeepMind 到 EleutherAI 到 AI21 Labs 的 NLG 領域的 OG。

所有人都傾注了巨大的努力和資源,使人類向前邁出了一步。

我們希望加入他們的行列,並鄙視那些渴望從他們的工作中獲得快速收益的人。

在 TextCortex,我們喜歡做艱苦的工作。

因為走捷徑不會建立持久和有競爭力的價值,因為它關係到你的核心。

創作的品質。

雖然 GPT-3 是一個多面手,一個真正的多面手,但對於 AI 文案的用例來說,它的規模已經很大。

就像人類已經從泛化到專業化,發展到今天的我們一樣。

這也將涉及自然語言生成。

這就是為什麼在 TextCortex,我們沒有開發一種適合所有人的模型。 我們構建小型目標驅動模型,建立和編排網絡。

因為“一刀切”,根本不適合所有。

我們構建了一個由 100 個和 1000 個模型組成的網絡,而不是一個龐大的萬億參數 AI 模型,它可以作為專家 AI 寫作夥伴。

我們正在根據我們自己精心挑選的知識和數據訓練、構建、測試、開發、試驗和部署我們自己的 AI 模型。

教他們成為通才世界的專家。

我們沒有提供 100 多個經常錯過與您的需求相關性的預寫模板,而是發布了我們專門探索、收集知識並訓練我們的 AI 掌握的模板。

為自己選擇合適的 AI 寫作工具

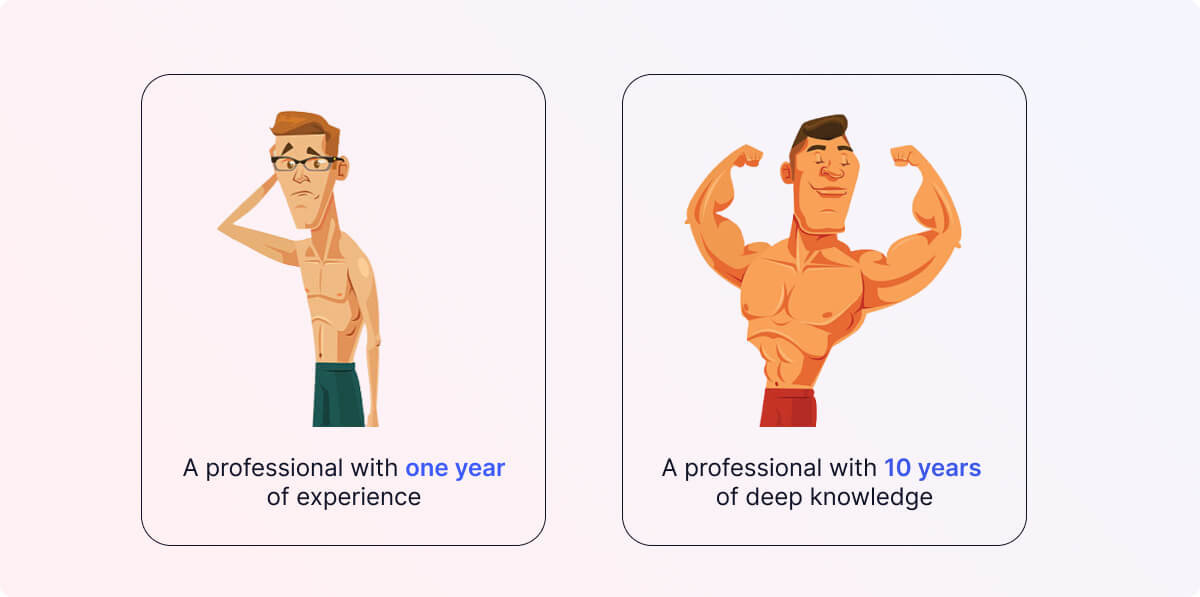

這是一個簡單的問題,您更喜歡什麼?

在您需要的領域中擁有一年經驗的專業人士還是擁有 10 年深厚知識的專業人士?

應該寫可靠合同的律師是否也需要知道如何撰寫有關巧克力鬆餅食譜的最吸引人的博客?

通過我們較小的目的驅動的人工智能模型方法,我們可以教他們某些格式和寫作風格的原因、方式和內容。

例如,我們的長模型在超過 1000 萬個高度參與的博客上進行了訓練。

他們明白,長篇內容包括對內容豐富的主要部分的引人入勝的介紹,以及將所有內容帶入一個重點的結論。

使 AI 模型適應我們的用戶需求是我們的日常工作。

我們每天都在努力擴大這個 AI 專家網絡,並將他們帶到您需要他們成為的每個文本框中。

你是一個狂熱的作家嗎?

查看我們的 chrome 擴展程序,在每個文本框中為您的作品充電。

您是正在尋找 NLG AI 解決方案的開發人員? 聯繫我們測試我們的 API。

您想為我們的事業貢獻數據嗎? 請做我們的客人。

讓我們有目的地構建有創意的 AI!