Website-A/B-Tests für CRO: Kurzanleitung 2022

Veröffentlicht: 2022-01-12Auf Ihrer Suche nach Möglichkeiten zur Optimierung der Konversionsrate Ihrer Website können Sie mit Sicherheit sagen, dass viele Male A/B-Tests durchgeführt werden müssen.

Nun, was ist der CRO-Test? Warum sollten Sie mit CRO A/B-Tests für Ihre Website beginnen? Wie führen Sie effektiv einen A/B-Test auf Ihrer Website durch?

All diese Fragen haben wir in diesem Beitrag beantwortet. Beginnen wir mit einer Definition.

Schnelle Navigation

- Was ist ein A/B-Test für CRO?

- Der Unterschied zwischen CRO- und SEO-A/B-Tests

- 1. Absichten und Ziele

- 2. Steuerelemente und Varianten

- 3. Versionen der Seiten

- Warum sollten Sie CRO A/B-Tests durchführen?

- 3 Top CRO-würdige A/B-Testsoftware

- 1. Google Optimize: Beginnen Sie Ihren A/B-Test mit dem kostenlosen Tool von Google

- 2. Optimizely – Enterprise A/B- und CRO-Tools zu wettbewerbsfähigen Preisen

- 3. VWO – Ähnlich wie Optimizely, aber viel budgetfreundlicher

- Wie führt man einen A/B-Test auf seiner Website durch?

- Schritt 1. Definieren Sie die Kerngeschäftsziele

- Schritt 2. Auswählen, was getestet werden soll

- Schritt 3. Beobachten und Hypothese formulieren

- Schritt 4. Erstellen Sie Variationen

- Schritt 5. Ausführen des Tests

- Schritt 6. Auswerten und Abschließen

- Tipps und Best Practices für A/B-Tests

- Einpacken

Was ist ein A/B-Test für CRO?

A/B-Testing (auch bekannt als Split-Testing oder Bucket-Testing) bedeutet in der Conversion-Rate-Optimierung (CRO) meist das Testen von Faktoren, die die Conversion-Rate einer Website beeinflussen: Text, Header, Bilder, Design, Calls-to- Action und Layout, um nur einige zu nennen. Es ist eine der am häufigsten verwendeten Techniken, um sicherzustellen, dass Ihre Website so eingerichtet ist, dass sie Benutzer durch Seiten führt und an entscheidenden Berührungspunkten konvertiert.

Der Unterschied zwischen CRO- und SEO-A/B-Tests

A/B-Tests für CRO unterscheiden sich stark von A/B-Tests für SEO. In diesem Teil wollen wir die einzelnen Techniken beleuchten, wie sie sich unterscheiden und wofür sie verwendet werden.

1. Absichten und Ziele

Obwohl CRO- und SEO-Tests beide A/B-Tests verwenden, sind ihre Ziele – und wie sie durchgeführt werden – sehr unterschiedlich. CRO zielt darauf ab, die Konversionsrate zu verbessern, sobald Besucher die Website erreicht haben; SEO-fokussierte Tests zielen darauf ab, die Anzahl der Besucher der Website zu erhöhen , indem technische Änderungen implementiert werden, die die Position der Website in den SERPs verbessern.

2. Steuerelemente und Varianten

Beim CRO A/B-Testing werden zwei Versionen derselben Seite eingerichtet und gleichzeitig live ausgeführt, und menschliche Benutzer werden auf eine zufällige umgeleitet. Somit sind es die Benutzer selbst, die in Controls und Varianten aufgeteilt werden. Es werden Daten darüber gesammelt, wie Benutzer mit der ihnen zugewiesenen Version der Seite interagieren, und verglichen.

Bei SEO-A/B-Tests werden Seiten in zwei Gruppen aufgeteilt – Kontrollen und Varianten. Änderungen werden nur auf den Variantenseiten vorgenommen und die gesammelten Daten mit einer zuvor ermittelten Leistungsprognose verglichen.

3. Versionen der Seiten

CRO A/B-Tests erfordern, dass zwei Versionen derselben Seite gleichzeitig live sind, damit Daten gesammelt und verglichen werden können.

Beim SEO-Split-Testing gibt es immer nur eine Version jeder Seite. Mit Google als Bestimmungsfaktor für das Ranking dieser Seiten wird duplizierter Inhalt (gegen den Google ist) nicht gefördert.

Zusammenfassend gibt es mehrere wesentliche Unterschiede zwischen CRO- und SEO-A/B-Tests. Beide Tests sind wichtige Schritte zur Verbesserung der Online-Leistung, zielen jedoch auf sehr unterschiedliche Metriken ab.

| CRO A/B-Tests | SEO-A/B-Tests |

| Jede einzelne Seite hat mehrere Variationen: ein Steuerelement und mindestens eine Variante | Mehrere Seiten innerhalb einer Seitenfamilie werden entweder gruppiert in: das Steuerelement oder die Variante. Von jeder einzelnen Seite gibt es immer nur eine Version |

| Optimiert für Besucher, sobald sie auf der Seite sind, indem die Benutzerfreundlichkeit und Benutzererfahrung der Seite verbessert werden | Optimiert für Google (und Suchende), indem technische Aspekte verbessert werden, die ihre Position in den SERPS erhöhen |

| Zielt darauf ab, die Anzahl der Personen zu erhöhen, die konvertieren, sobald sie auf der Seite sind | Zielt darauf ab, den Verkehr zu erhöhen |

| Verwendet Google Optimize und Optimize 360 zur Prüfung auf statistische Signifikanz | Prognostiziert den Datenverkehr und überprüft dann die statistische Signifikanz anhand von Prognosen mit Google Analytics/GA 360 |

Warum sollten Sie CRO A/B-Tests durchführen?

Der Hauptgrund, warum CRO-Tests wichtig sind, ist, dass sie es Marketern ermöglichen, die bestmögliche Alternative zu testen, die das Potenzial hat, die höchstmögliche Konversionsrate zu erzielen, indem sie weniger investieren.

Wenn Sie beispielsweise die Seite „Warenkorb“ eines Online-Bestellportals verlassen, ohne die eigentliche Bestellung aufzugeben, führt dies dazu, dass der Website- oder Produktentwickler darüber nachdenkt, was Sie dazu veranlasst hat. War es Interessenverlust? Ist ein Zeitraffer aufgetreten? War das Produkt teurer als das, was Sie budgetiert hatten? Oder war es nur der gesamte Bestellvorgang? Wenn kein Test durchgeführt wird, können Sie niemals Informationen über das Kundenverhalten sammeln und analysieren, um die Konversionsrate auf Ihrer Website zu beurteilen.

Das Testen beseitigt das Rätselraten bei der Website-Optimierung und ermöglicht datengestützte Entscheidungen, die Geschäftsgespräche von „wir denken“ zu „wir wissen“ verlagern. Indem Sie die Auswirkungen messen, die Änderungen auf Ihre Metriken haben, wissen Sie, was auf Ihrer Website funktioniert.

Es ist die perfekte Methode, um die Konversionsrate zu verbessern, den Umsatz zu steigern, Ihre Abonnentenbasis zu vergrößern und Ihre Ergebnisse bei der Kundengewinnung und Lead-Generierung zu verbessern.

3 Top CRO-würdige A/B-Testsoftware

Die Durchführung eines erfolgreichen A/B-Tests erfordert eine datengestützte Hypothese, ein effektives A/B-Testtool und ein System zum Sammeln von Feedback, das Ihnen zur Verfügung steht, um die Ergebnisse genau auszuführen und zu analysieren.

In diesem Teil stellen wir Ihnen 3 kostenlose und kostenpflichtige CRO-würdige A/B-Testsoftware vor.

Also lasst uns das vernichten.

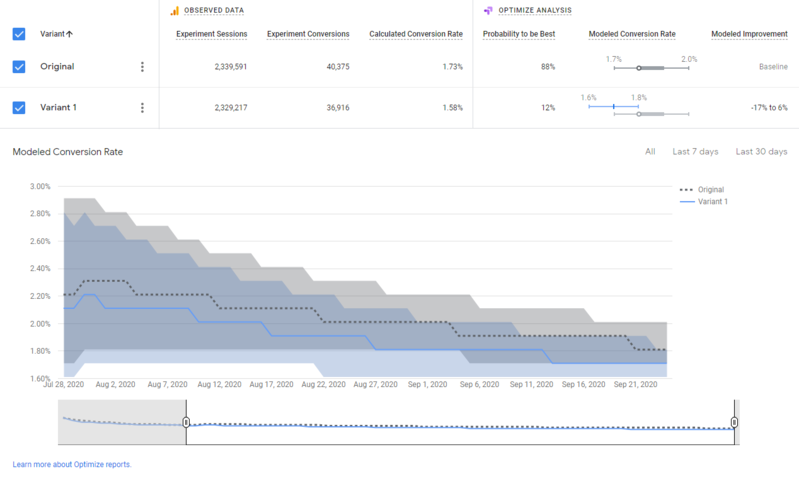

1. Google Optimize: Beginnen Sie Ihren A/B-Test mit dem kostenlosen Tool von Google

Google Optimize ist ein Split-Testing-Tool, das mit Google Analytics bereitgestellt wird. Wenn Sie nach einer leistungsstarken AB-Testlösung ohne finanzielle Kosten suchen, suchen Sie nicht weiter.

Google Optimize ist ein nützliches A/B-Testtool, mit dem Sie verschiedene Versionen Ihrer Website erstellen, testen und analysieren können. Auf Wunsch können Sie auch einfache Split-URL-Tests und multivariate Tests durchführen.

Neben Testfunktionen bietet es auch serverseitige Tests, anpassbare URL-Regeln, Erlebnispersonalisierung und mehr, sodass Sie Online-Erlebnisse testen und bereitstellen können, um Besucher anzusprechen.

Hauptfunktionen von Google Optimize:

- Mit Google Optimize können Sie A/B-Tests, multivariate Tests, Split-URL-Tests und Umleitungstests durchführen.

- Optimize hat auch einen WYSIWYG-Editor, damit Sie Ihre Variationen schnell für jedes Gerät erstellen und bereitstellen können.

- Sie können Ihre Zielgruppe nach Quelle, Gerät, Standort usw. segmentieren, um ihre Erfahrung zu personalisieren.

- Sie können damit Zielsetzungen und Ziele festlegen, um den Erfolg Ihrer Hypothese zu messen, während Sie den Test durchführen.

- Die Analyse-Engine von Google Optimize verwendet Bayes'sche Inferenz, um Ihnen die Echtzeitleistung Ihrer Variationen im Vergleich zur Kontrolle anzuzeigen, z. B. Erfolgswahrscheinlichkeitsvarianten, Konversionsratenvergleich, statistische Signifikanz, Konfidenzniveau usw.

- Optimize ist auch nativ in Google Analytics integriert, sodass Sie Echtzeit-Einblicke in das Besucherverhalten, die Website-Leistung, die Zielgruppensegmentierung, die Verkehrsquellen usw. erhalten.

2. Optimizely – Enterprise A/B- und CRO-Tools zu wettbewerbsfähigen Preisen

Für größere Unternehmen ist Optimizely oft die bevorzugte Wahl für erstklassige A/B-Testtools.

Mit ihrem leistungsstarken A/B- und mehrseitigen Experimentiertool können Sie mehrere Experimente gleichzeitig auf einer Seite durchführen und so verschiedene Variablen Ihres Webdesigns testen.

Optimizely bietet auch Tests auf dynamischen Websites, verschiedene Experimentdimensionen wie eine Werbekampagne, Geographie und Cookies sowie verschiedene Segmentierungsparameter für Experimente wie Gerät, Browser und Kampagne an.

Optimizely Hauptmerkmale:

- Führen Sie A/B-Tests und mehrseitige Tests effizient durch.

- Es bietet einen leistungsstarken visuellen Editor zum Erstellen und Testen von Variationen.

- Sie können den Varianten den Traffic manuell zuweisen oder den Stats Accelerator verwenden, um den Traffic je nach Besucherverhalten automatisch zu verteilen.

- Empfehlungs-Engine: Richten Sie Empfehlungen ein und testen Sie verschiedene Algorithmen

- Es enthält Optionen wie: benutzerdefiniertes Targeting, Priorisierung der Zielgruppe, benutzerdefinierte Vorlagen, einen visuellen Editor, Entwicklertools und APIs.

3. VWO – Ähnlich wie Optimizely, aber viel budgetfreundlicher

VWO ((Visual Website Optimizer) ist auch ein beliebtes A/B-Testtool im Marketingbereich. Es ist nicht nur die erste Wahl für Unternehmen mit kleineren Budgets, sondern wird auch häufig in Verbindung mit Optimizely von Unternehmen verwendet, die komplexe Tests durchführen Kampagnen.

VWO-Hauptmerkmale:

- Führen Sie A/B-Tests, multivariate Tests und Split-URL-Tests durch, um Ihre Variationen zu testen.

- Es bietet Sitzungsaufzeichnung, Heatmaps, On-Page-Umfragen usw., um echte Einblicke in das Besucherverhalten und -erlebnis zu erhalten.

- Mit dem benutzerfreundlichen visuellen Editor können Sie Testvariationen in wenigen Minuten erstellen.

- Ermöglicht Besuchersegmentierung wie mobiler vs. Desktop-Traffic oder neue vs. wiederkehrende Besucher, oder Sie können benutzerdefinierte Dimensionen verwenden, um neue Segmentierungen zu erstellen.

- Verfügbare Integrationen: Google Analytics, Kissmetrics, Demandware, Magento und andere.

Wie führt man einen A/B-Test auf seiner Website durch?

Unabhängig davon, welche A/B-Testing-Tools Sie verwenden oder welches Objekt Sie testen, folgt jeder A/B-Test auf der Welt ähnlichen Mustern:

Schritt 1. Definieren Sie die Kerngeschäftsziele

Wie bei allem im Leben brauchen Sie ein klares Ziel, um die späteren Testentscheidungen zu untermauern. Ihre Ziele sind die Metriken, die Sie verwenden, um festzustellen, ob die Variation erfolgreicher ist als die ursprüngliche Version. Ziele können alles sein, vom Klicken auf eine Schaltfläche oder einen Link bis hin zu Produktkäufen und E-Mail-Anmeldungen.

Und zum größten Teil sollten Sie sich die folgenden A/B-Testmetriken ansehen :

- Lösung von UX-Problemen und häufigen Besucherproblemen

- Verbesserung der Leistung aus bestehendem Traffic (höhere Conversions und Einnahmen, Verbesserung der Kosten für die Kundenakquise)

- Steigerung des Gesamtengagements (Reduzierung der Absprungrate, Verbesserung der Klickrate und mehr.)

Schritt 2. Auswählen, was getestet werden soll

Wenn es um die Optimierung der Konversionsrate Ihrer Website geht, können Ihre Testoptionen basierend auf Ihrem Ziel in 3 Haupttypen eingeteilt werden:

- Elementtests : Einzelne Elemente innerhalb einer Seite. Bsp.: Überschrift, Schaltflächen, Text etc.

- Seitentest : Kombinationen vieler Elemente. Beispiel: Seitenlayouts.

- Testen des Besucherflusses : Die Aktion, die Sie von Besuchern beim Betreten Ihrer Website erwartet haben. Beispiel: Checkout in mehreren Schritten vs. Checkout in einem Schritt.

Basierend auf Recherchen und praktischen Erfahrungen entscheiden Sie, was Sie testen möchten, um die Konversionsrate Ihrer Website zu verbessern.

Schritt 3. Beobachten und Hypothese formulieren

Ein A/B-Test beginnt mit der Identifizierung eines Problems, das Sie lösen möchten, oder eines Benutzerverhaltens, das Sie fördern oder beeinflussen möchten. Nach der Identifizierung schließt der Marketer normalerweise eine Hypothese – eine fundierte Vermutung, die die Ergebnisse des Experiments entweder validiert oder widerlegt.

Eine Hypothese sieht typischerweise so aus:

„Wenn den Produktdetailseiten ein Social-Proof-Badge hinzugefügt wird, erhöht sich die Konversionsrate um 10 %, da sie die Besucher über die Beliebtheit des Produkts informiert.“

Wie Sie sehen, verschafft Ihnen eine richtige Hypothese einen guten Überblick darüber, was geändert werden würde, welche Auswirkungen die Änderungen haben und welchen Mechanismus hinter den Auswirkungen steckt.

Schritt 4. Erstellen Sie Variationen

Der nächste Schritt in Ihrem Testprogramm sollte darin bestehen, eine Variation basierend auf Ihrer Hypothese zu erstellen und sie mit der vorhandenen Version (Kontrolle) A/B zu testen. Eine Variante ist eine andere Version Ihrer aktuellen Version mit Änderungen, die Sie testen möchten. Sie können mehrere Varianten gegen die Kontrolle testen, um zu sehen, welche am besten funktioniert.

Schritt 5. Ausführen des Tests

Sobald die Variationen bereit sind, starten Sie diese Variationen in genau derselben Umgebung, um den Test zu starten. Abhängig von der Art des Stücks, Ihrem Website-Traffic und der statistischen Signifikanz, die erreicht werden muss, kann der Test zwischen einigen Stunden und einigen Wochen dauern.

Schritt 6. Auswerten und Abschließen

Anhand Ihrer vorab aufgestellten Hypothese und Schlüsselmetriken ist es an der Zeit, Ihre Ergebnisse zu interpretieren. Unter Berücksichtigung der Konfidenzniveaus ist es notwendig, die statistische Signifikanz mit Hilfe Ihres Testwerkzeugs zu bestimmen.

Wenn keine der Varianten zu statistisch signifikanten Ergebnissen geführt hat – das heißt, der Test war nicht schlüssig – stehen mehrere Optionen zur Verfügung. Zum einen kann es sinnvoll sein, die ursprüngliche Variante einfach beizubehalten. Sie können auch Ihr Signifikanzniveau überdenken oder bestimmte KPIs aus dem Kontext des getesteten Teils neu priorisieren. Schließlich kann eine stärkere oder drastisch andere Variante in Ordnung sein.

Tipps und Best Practices für A/B-Tests

Im Folgenden finden Sie einige Best Practices für A/B-Tests, die Ihnen helfen können, Probleme zu vermeiden.

- Stellen Sie die Datenzuverlässigkeit für die A/B-Testlösung sicher

Führen Sie mindestens einen A/A-Test durch, um eine zufällige Zuordnung des Datenverkehrs zu verschiedenen Versionen sicherzustellen.

- Testen Sie eine Variable nach der anderen

Dadurch ist es möglich, den Einfluss der Variablen genau zu isolieren. Wenn die Position einer Aktionsschaltfläche und ihre Beschriftung gleichzeitig geändert werden, ist es unmöglich festzustellen, welche Änderung die beobachtete Auswirkung hatte.

- Anzahl der Variationen an Lautstärke anpassen

Bei vielen Variationen für wenig Verkehr dauert der Test sehr lange, bevor er interessante Ergebnisse liefert. Je geringer der dem Test zugeordnete Traffic ist, desto weniger Versionen sollten unterschiedlich sein.

- Segmenttests

In manchen Fällen ist es unsinnig, einen Test bei allen Nutzern einer Seite durchzuführen. Zielt ein Test darauf ab, den Einfluss verschiedener Formulierungen von Kundenvorteilen auf die Registrierungsrate einer Seite zu messen, ist die Übermittlung der aktuellen Datenbank der registrierten Nutzer wirkungslos. Der Test sollte stattdessen neue Besucher ansprechen.

- Lassen Sie die Tests lange genug laufen

Auch wenn ein Test schnell statistische Zuverlässigkeit zeigt, müssen die Stichprobengröße und wochentagsabhängige Verhaltensunterschiede berücksichtigt werden. Es ist ratsam, einen Test mindestens eine Woche laufen zu lassen, idealerweise zwei

- Warten Sie, bis Sie eine statistische Zuverlässigkeit haben, bevor Sie handeln

Solange der Test keine statistische Zuverlässigkeit von mindestens 95 % erreicht hat, ist von einer Entscheidung abzuraten. Ansonsten ist die Wahrscheinlichkeit sehr hoch, dass beobachtete Ergebnisunterschiede auf Zufall und nicht auf vorgenommene Modifikationen zurückzuführen sind.

- Wissen, wann ein Test beendet werden muss

Wenn ein Test zu lange dauert, um eine Zuverlässigkeitsrate von 95 % zu erreichen, hat das getestete Element wahrscheinlich keinen Einfluss auf den gemessenen Indikator. In diesem Fall ist es sinnlos, den Test fortzusetzen, da dies unnötigerweise einen Teil des Verkehrs monopolisieren würde, der für einen weiteren Test verwendet werden könnte.

- Beachten Sie Marketingaktionen während eines Tests

Externe Variablen können die Ergebnisse eines Tests verfälschen. Häufig ziehen Traffic-Akquisitionskampagnen eine Gruppe von Benutzern mit ungewöhnlichem Verhalten an. Es ist vorzuziehen, Nebenwirkungen zu begrenzen, indem diese Art von Tests oder Kampagnen erkannt werden.

Einpacken

A/B-Tests sind eine der leistungsstärksten und effektivsten Methoden zur Verbesserung der Konversionsrate. Nachdem Sie diesen umfassenden Artikel über A/B-Tests zur Optimierung der Konversionsrate gelesen haben, sollten Sie nun vollständig gerüstet sein, um Ihre eigene Optimierungs-Roadmap zu planen.

Wenn Sie diesen Leitfaden nützlich fanden, sagen Sie es weiter und helfen Sie anderen erfahrenen Optimierern bei A/B-Tests, ohne auf die häufigsten Fallstricke hereinzufallen. Viel Spaß beim Testen!