5 ошибок, которых следует избегать в ваших картах сайта

Опубликовано: 2022-03-15Мы создали инструмент, который позволяет нам проверять, сколько страниц на данном сайте проиндексировано в Google .

На данный момент мы проверили сотни веб-сайтов, и этот инструмент помог нам диагностировать SEO-проблемы, с которыми сталкивались наши клиенты, например связанные с краулинговым бюджетом и индексацией.

Мы часто сталкиваемся с аномалиями данных при расследовании этих проблем и видим множество веб-сайтов с серьезными ошибками в картах сайта.

Как это может повлиять на ваш сайт?

Если ваша карта сайта не реализована должным образом, робот Googlebot может потратить много времени на сканирование некачественных URL-адресов, что является пустой тратой краулингового бюджета. В результате многие ценные URL-адреса на вашем веб-сайте могут быть не проиндексированы в Google , поскольку у Google не будет достаточно ресурсов для их сканирования.

Какие ошибки допускают популярные веб-сайты в своих картах сайта и как их избежать, чтобы Google не тратил краулинговый бюджет на нерелевантный контент?

Давайте копать.

Каков краулинговый бюджет?

Во- первых, позвольте мне объяснить, что такое краулинговый бюджет и насколько он важен для индексации веб-сайта.

Google может сканировать большое количество контента, но его ресурсы не безграничны , поэтому ему нужно делать выбор, используя имеющиеся у него ресурсы.

Вот почему Googlebot определяет бюджет сканирования для всех веб-сайтов — количество URL-адресов, которые он может и хочет сканировать.

Бюджет сканирования сайта зависит от двух показателей :

- Ограничение мощности сканирования — рассчитано для сканирования всего важного контента на веб-сайте без превышения ограничений его сервера — и,

- Спрос на сканирование — определяется размером веб-сайта, популярностью и частотой обновления.

Если сайт тормозит или отвечает ошибками сервера, лимит уменьшается и робот Googlebot сканирует меньше.источник: документация Google

Из-за ограниченных возможностей робота Googlebot вам следует планировать, какие URL-адреса робота Googlebot будут сканировать на вашем веб-сайте.

Ключ к настройке того, какие URL сканируются, объясняется в документации Google:

Управляйте своими URL-адресами: используйте соответствующие инструменты, чтобы указать Google, какие страницы сканировать, а какие нет. Если Google тратит слишком много времени на сканирование URL-адресов, не подходящих для индекса, робот Googlebot может решить, что не стоит тратить время на просмотр остальной части вашего сайта.источник: документация Google

Резюмируя — вот что мы знаем на данный момент:

- Если ваш веб-сайт работает медленно, Google может сканировать меньше URL-адресов, поэтому меньшее количество URL-адресов попадет в индекс Google.

- Если при сканировании вашего сайта Google обнаружит много некачественных URL-адресов, он может решить, что общее качество вашего сайта низкое.

Вот важный вывод:

Поскольку Google может сканировать множество некачественных URL-адресов, робот Googlebot может потерять много времени на их сканирование и не сможет сканировать многие высококачественные URL-адреса на вашем веб-сайте.

Это имеет наибольшее значение для крупных или быстро меняющихся веб-сайтов, поскольку их необходимо часто и тщательно сканировать, чтобы привлечь трафик.

Насколько карты сайта важны для вашего краулингового бюджета?

Как я уже объяснял, оптимизация краулингового бюджета — чрезвычайно важный шаг для индексации вашего сайта.

Одним из способов управления инвентарем URL -адресов является создание и поддержание хорошо оптимизированной карты сайта.

Карта сайта — это файл, в котором вы предоставляете информацию о страницах, видео и других файлах на вашем сайте, а также о связях между ними […]. Карта сайта сообщает Google, какие страницы и файлы, по вашему мнению, важны на вашем сайте, а также предоставляет ценную информацию об этих файлах. Например, время последнего обновления страницы и все версии страницы на альтернативном языке.источник: документация Google

Тем не менее, множество веб-сайтов не могут создать хорошо оптимизированные карты сайта. К счастью, мы можем учиться на их ошибках.

Каких ошибок следует избегать в карте сайта?

Я проанализировал многие популярные сайты и обнаружил, что многие из них допускают ошибки в картах сайта, которые негативно влияют на их краулинговый бюджет, что может привести к проблемам с охватом их индекса.

Вот мой список ошибок, которых следует избегать при создании карты сайта.

Отправка неверных URL-адресов

Одна из обнаруженных мной ошибок касалась структуры URL-адресов в картах сайта.

Проанализируем это на конкретном примере.

Whisky.de

Когда я увидел статистику, собранную нашим программным обеспечением, я был ошеломлен: она показала, что 0% страниц виски.де, представленных в картах сайта, были проиндексированы в Google.

Я знал, что это не может быть правдой, поэтому я исследовал данные дальше.

Большинство URL-адресов в картах сайта whisky.de кажутся действительными:

- Они были каноническими,

- Они не были заблокированы метатегом noindex robots,

- Они не были заблокированы директивой disallow в robots.txt,

- Они отвечали кодом состояния 200.

Но затем я заметил, что все URL-адреса имели двойную косую черту после домена верхнего уровня — взгляните на этот пример:

- https://www.whisky.de//wissen/herstellung/hintergrundwissen/fasstypen/whisky-in-marsala-weinfaessern.html

- https://www.whisky.de//wissen/herstellung/hintergrundwissen/jim-beam-fassfabrik.html

- https://www.whisky.de//presse/pressespiegel/playboy.html

Двойная косая черта кажется очевидной программной ошибкой при создании карт сайта, которую легко исправить.

Однако страницы, включенные в карты сайта, имеют канонические теги, указывающие на соответствующие URL-адреса — их правильные версии с одной косой чертой.

В результате весьма вероятно, что Google посещает в два раза больше URL-адресов, чем предполагалось: URL-адреса с одинарной и двойной косой чертой.

У Google есть механизмы для обнаружения ошибочных шаблонов в URL-адресах, и с технической точки зрения вполне возможно, что Google заметил ошибку. Таким образом, он может соответствующим образом сканировать виски.де и индексировать правильно структурированные URL-адреса. Но у нас нет возможности проверить это без доступа к учетной записи Google Search Console или журналам сервера.

На практике вам не следует полагаться на алгоритмы Google для исправления своих ошибок — методы, подобные описанному мной, могут увеличить нагрузку на ваш краулинговый бюджет и даже не допустить попадания ваших страниц в индекс Google.

Отправка URL-адресов тонкого контента

Существует множество веб-сайтов, которые включают страницы с тонким контентом в свои карты сайта.

Позвольте мне показать вам пример.

ЭннТейлор

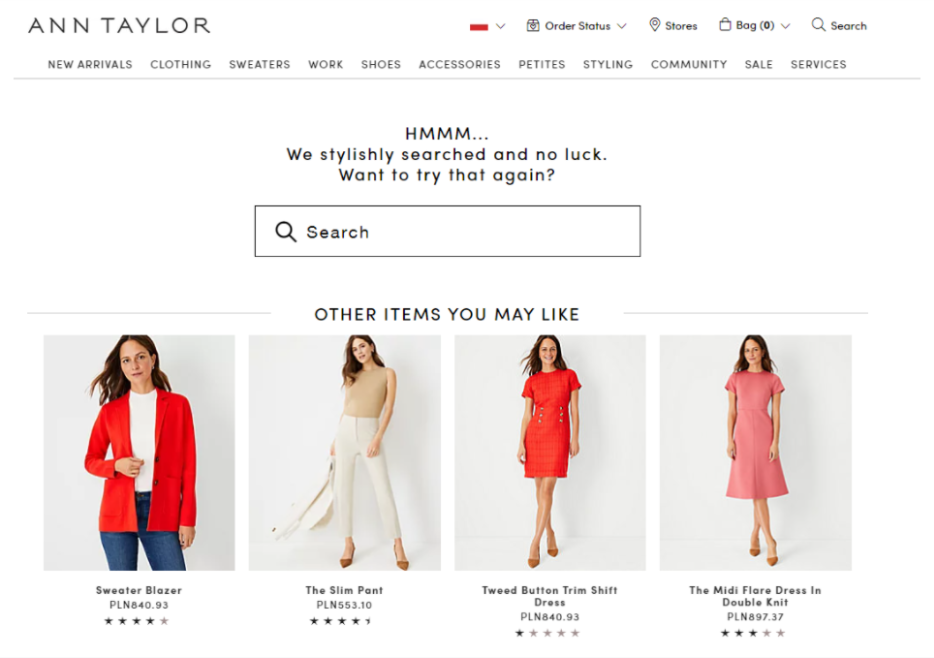

Я обнаружил эту ошибку на AnnTaylor.com, самом популярном магазине женской одежды.

Я хотел проверить, сколько их категорий продуктов было проиндексировано в Google, поэтому я изучил их карту сайта, посвященную страницам категорий.

Первоначальная проверка показала, что только 46% страниц категорий были проиндексированы в Google.

Итак, я изучил это более подробно и узнал, что большинство страниц их категорий были мягкими 404.

В частности, на этих страницах отображалось следующее сообщение:

Неудивительно, что Google не захотел их индексировать!

Следующим логическим шагом было исключение программных 404 из моей выборки. Для этой цели я проверил статус индексации той же карты сайта, но использовал триггер, который исключал страницы, содержащие фразу «Мы стильно искали, но безуспешно», как показано на изображении выше.

Выяснилось, что после исключения URL-адресов с программным кодом 404 индексируется 82% страниц в карте сайта соответствующей категории.

Тем не менее, 18% страниц категорий не проиндексированы в Google — это то, на чем должны сосредоточиться их SEO-специалисты.

Ситуация ЭннТейлор серьезна по следующим причинам:

- Во-первых, Google тратит краулинговый бюджет на сканирование разреженного контента.

- Кроме того, не секрет, что Google оценивает качество на трех уровнях: страница, раздел и сайт в целом. Google может решить, что страницы категорий в целом имеют низкое качество и все они могут быть деиндексированы . В прошлом это случалось с такими сайтами, как Giphy, Instagram или Pinterest, как я описал в одной из своих статей. Будем надеяться, что с ЭннТейлор этого не случится.

Пропуск ценных URL-адресов

Как я уже упоминал, карты сайта помогают Google лучше понять ваш сайт и сканировать его более разумно.

Однако я заметил, что многие веб-сайты не включают свои наиболее ценные URL-адреса в карты сайта.

Вот один пример.

GoodReads

Я проверил общую выборку (взятую из всех URL-адресов из карт сайта ) для GoodReads и обнаружил, что только 35% из них были проиндексированы.

Я был очень удивлен, так как знаю, что это очень качественный сайт. Я знаю, что я не единственный, кто посещает GoodReads, чтобы прочитать отзывы и узнать, стоит ли читать ту или иную книгу.

Затем я увидел, что в проверенном нами образце не было URL-адресов с включенными книгами. Поэтому я решил скачать все их карты сайта.

Результат: нет ссылок с книгами в картах сайта.

Почему это плохой знак?

Существует риск того, что Google отдает приоритет URL-адресам, найденным в картах сайта, и каким-то образом пропускает посещение страниц продуктов.

Отказ от ответственности: GoodReads не является нашим клиентом. Таким образом, с технической точки зрения вполне возможно, что у них есть частная карта сайта, отправленная в Google Search Console.

Злоупотребление параметром <lastmod>

Одним из параметров, которые вы можете включить в свой файл карты сайта, является <lastmod>, указывающий время последнего обновления страницы. Таким образом, Google может легко выбрать URL-адреса, которые недавно изменились.

Однако некоторые веб-сайты злоупотребляют этой техникой. И это может иметь неблагоприятные последствия, потому что, как мы читаем в рекомендациях Google, « Google использует значение <lastmod>, если оно последовательно и проверяемо (например, путем сравнения с последней модификацией страницы) точно».

Давайте рассмотрим пример сайта, который злоупотребляет параметром <lastmod>.

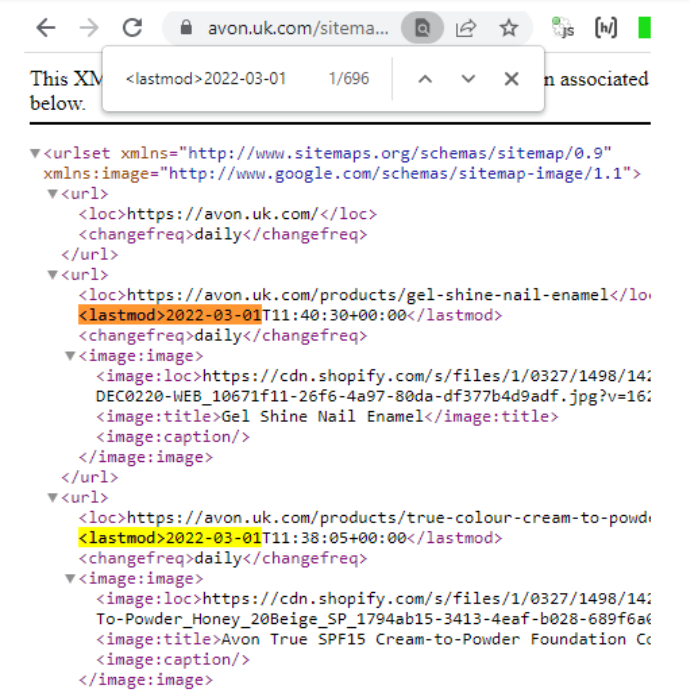

Эйвон

Я просмотрел карту сайта Avon, и все перечисленные URL-адреса имеют один и тот же параметр <lastmod> — текущий день:

Можно с уверенностью предположить, что не все URL-адреса Avon меняются ежедневно, поэтому Google неохотно индексирует свои страницы.

Связывание с вашей промежуточной средой в картах сайта

Google довольно часто индексирует промежуточные URL-адреса.

Обычно остается загадкой, как Google находит ссылки на такие страницы. Но общее объяснение состоит в том, что эти URL-адреса связаны непосредственно с картами сайта.

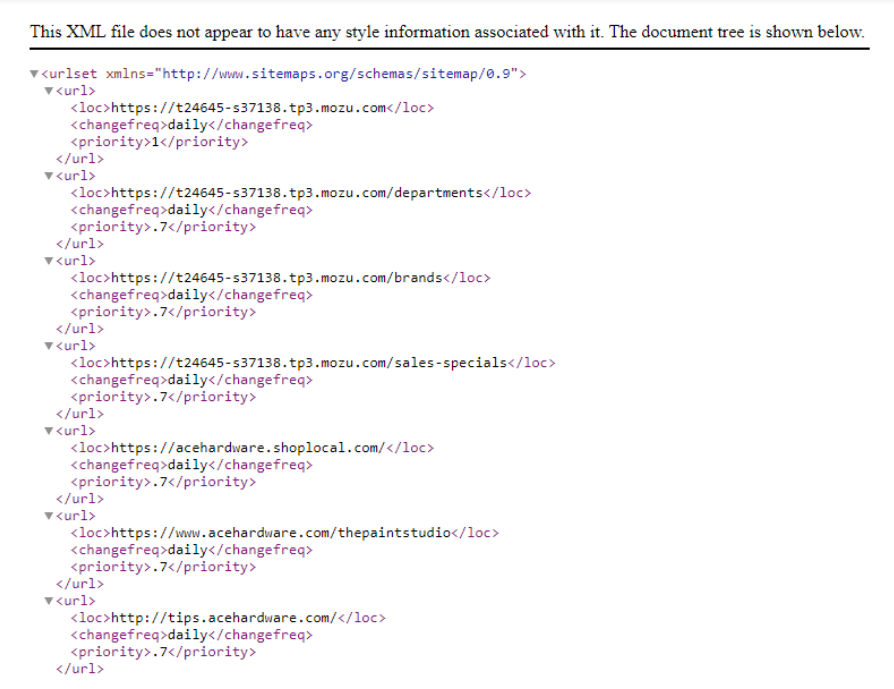

Acehardware.com

Обратите внимание, что с тех пор сайт acehardware.com обновил карты сайта и устранил указанную ниже ошибку.

Вот образец, который я сначала проверил.

Как видите, я обнаружил, что они ссылались на промежуточный сайт со своей карты сайта.

Почему плохо включать промежуточную среду в карту сайта?

- Google сканирует ненужные URL-адреса.

- Если промежуточные URL-адреса проиндексированы, они сбивают с толку пользователей, ищущих конкретную информацию, и натыкаются на них в результатах поиска.

Рекомендации, которым следует следовать в картах сайта

Вы ознакомились с моим обзором того, чего следует избегать при создании и управлении картой сайта для веб-сайта.

Итак, каковы некоторые практики, которым вы должны следовать?

Вот несколько лучших практик, которые я рекомендую:

– Включайте в карты сайта только канонические URL -адреса.

– Максимальный размер карты сайта должен составлять 50 000 URL-адресов. Вы можете разбить их на более мелкие карты сайта, если у вас больше URL-адресов.

– Не включайте идентификаторы сеансов из ваших URL-адресов в карты сайта – таким образом вы можете уменьшить дублирование сканирования заданных URL-адресов.

– Используйте согласованные и полные URL-адреса – включайте абсолютные , а не относительные URL-адреса.

Как я уже упоминал, убедитесь, что ваши карты сайта содержат только ценные URL-адреса. Вы можете выполнить полное сканирование веб-сайта, чтобы проверить, отсутствуют ли какие-либо URL-адреса, найденные при сканировании, в вашей карте сайта.

Это только верхушка айсберга, когда дело доходит до оптимизации вашей карты сайта — для получения дополнительных рекомендаций прочитайте наше окончательное руководство по XML-картам сайта.

Подведение итогов

Файлы Sitemap важны для каждого веб-сайта.

Тем не менее, как вы можете видеть из примеров сайтов, которые я перечислил, многие популярные веб-сайты не имеют оптимизированных файлов Sitemap, что дорого обходится – их покрытие индексом сильно страдает.

Кроме того, имейте в виду, что ошибки SEO в картах сайта могут негативно повлиять на ваш краулинговый бюджет, что имеет решающее значение, если у вас средний или большой веб-сайт.

Я надеюсь, что теперь вы знаете, каких ошибок следует избегать, и вы будете на пути к созданию карты сайта, которая поможет Google более эффективно сканировать ваш сайт, что приведет к улучшению охвата индекса.