Bing vs. Google: care motor de căutare indexează mai mult conținut?

Publicat: 2022-03-15Motoarele de căutare nu pot descoperi și indexa fiecare pagină de pe web – trebuie să facă alegeri în acest sens. Și, deși toate motoarele de căutare au același scop, ele folosesc criterii diferite pentru paginile de indexat.

Acestea fiind spuse, este în general bine dacă un motor de căutare poate accesa cu crawlere și indexa cât mai mult conținut valoros posibil - crește șansele ca acesta să arate utilizatorilor ceea ce caută.

Eram curios despre ce motor de căutare – Bing sau Google – indexează mai mult conținut în general.

Acest articol descrie diferitele aspecte ale cercetării mele și, deși aș avea nevoie de mai multe date pentru a trage concluzii definitive, am reușit totuși să adun multe perspective unice și valoroase.

Iată ce am descoperit despre cum Bing și Google indexează paginile web.

Analiza datelor de indexare: metodologie și rezultate

Acoperire indexată a unui eșantion aleatoriu de site-uri WordPress

Primul pas al cercetării mele a fost să colectez un eșantion de pagini pentru a le verifica statisticile de indexare.

Am decis că un bun punct de plecare ar fi să folosesc un eșantion de site-uri web folosind pluginul Yoast SEO WordPress. A existat un motiv practic în spatele alegerii acestui plugin: împarte sitemapurile pe secțiuni, ceea ce m-ar permite să analizez care secțiuni sunt indexate cel mai mult.

Am găsit o listă de site-uri web care folosesc pluginul Yoast SEO pe builtwith.com , un site care raportează site-uri web folosind tehnologii sau instrumente date. Am ales un eșantion aleatoriu de 200 de site-uri web dintr-o listă de site-uri care folosesc Yoast SEO.

Apoi, am verificat statisticile de indexare ale acelor site-uri web folosind ZipTie.dev , iar datele care au ieșit sunt foarte interesante.

Bing a indexat mai multe pagini web decât Google.

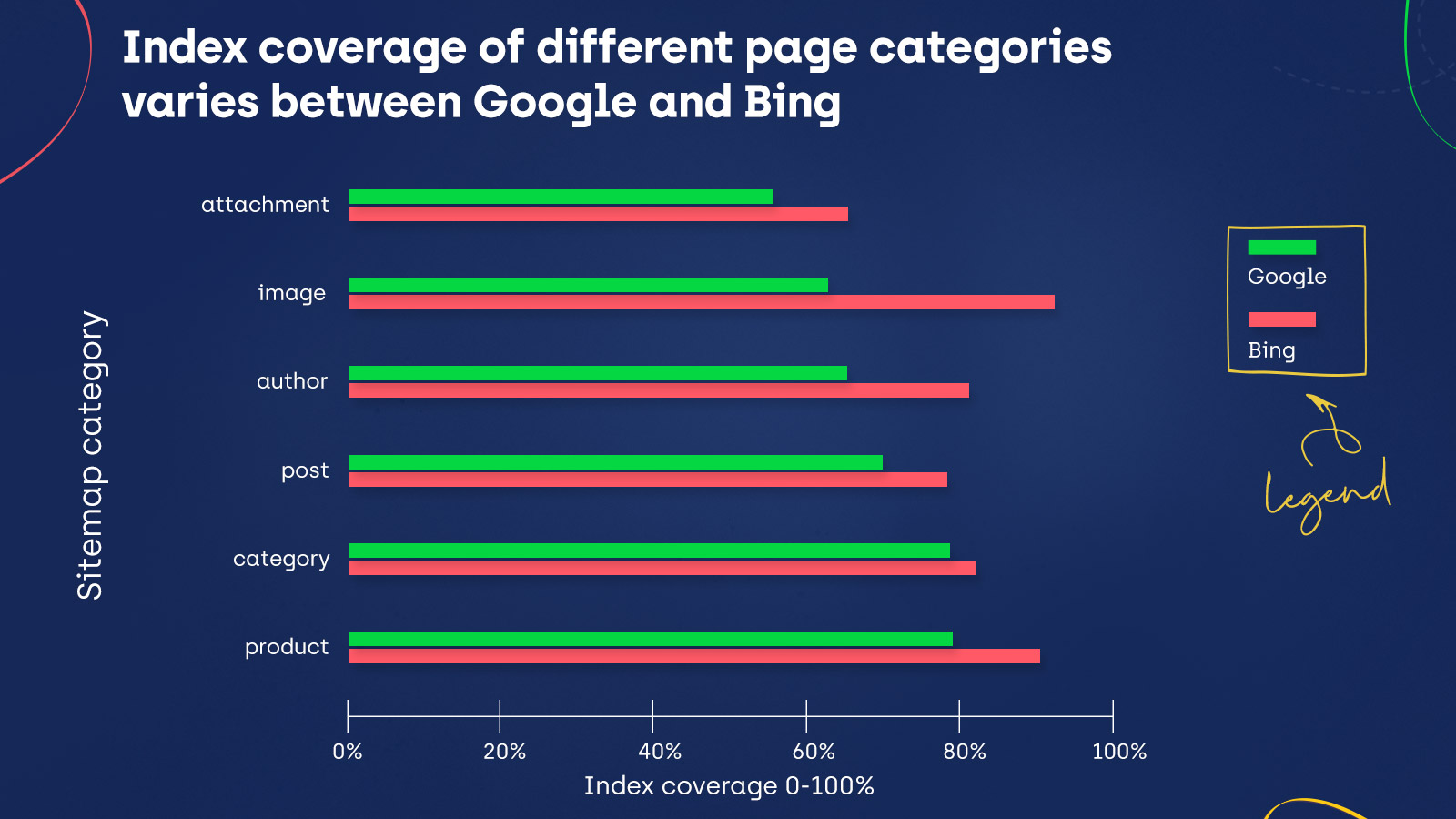

Aruncă o privire la graficele de mai jos care arată statisticile de indexare pentru anumite categorii de sitemap:

Acoperirea indexului este aceeași pentru Bing și Google pentru categoriile de povești și presă. Mai mult, Google a indexat mai mult conținut în ghiduri și locații. Cu toate acestea, în toate celelalte categorii de sitemap, indexarea Bing o depășește pe cea a Google – inclusiv categorii importante, cum ar fi postări, produse și imagini.

Dar asta înseamnă că Bing poate accesa cu crawlere mai multe pagini decât Google? Sau accesează cu crawlere cantități similare de conținut, dar au preferințe diferite când vine vorba de indexare?

Datele cu crawlere pentru un eșantion de clienți noștri

Pentru a extinde constatările mele, am verificat datele pentru câțiva dintre clienții noștri atât în Bing Webmaster Tools , cât și în Google Search Console.

Aceste instrumente arată paginile despre care motorul de căutare respectiv le cunoaște pentru un anumit domeniu.

În Google Search Console, m-am uitat la Toate paginile cunoscute care apar în raportul Acoperire index și am verificat numărul de adrese URL pentru toate cele patru stări (Erori, Valid, Valid cu avertismente și Exclus).

În Bing Webmaster Tools, în secțiunea Site Explorer, care conține date de indexare pentru paginile de pe un anumit domeniu, am filtrat vizualizarea pentru a afișa Toate URL-urile.

Acest lucru mi-a arătat toate adresele URL descoperite pentru fiecare domeniu pe care l-am analizat.

După ce am comparat datele pe care le-am obținut în ambele instrumente, am observat că Google a descoperit mai multe pagini decât Bing.

Pe de altă parte (presupunând că aceste constatări sunt consecvente în ambele mostre de site-uri web testate), știm deja că paginile descoperite de Google și Bing au mai multe șanse să fie indexate de Bing.

Rețineți că aceste rezultate sunt doar pentru un eșantion mic de site-uri și este posibil să nu reprezinte întregul web.

Acoperire indexată a unui eșantion de site-uri populare

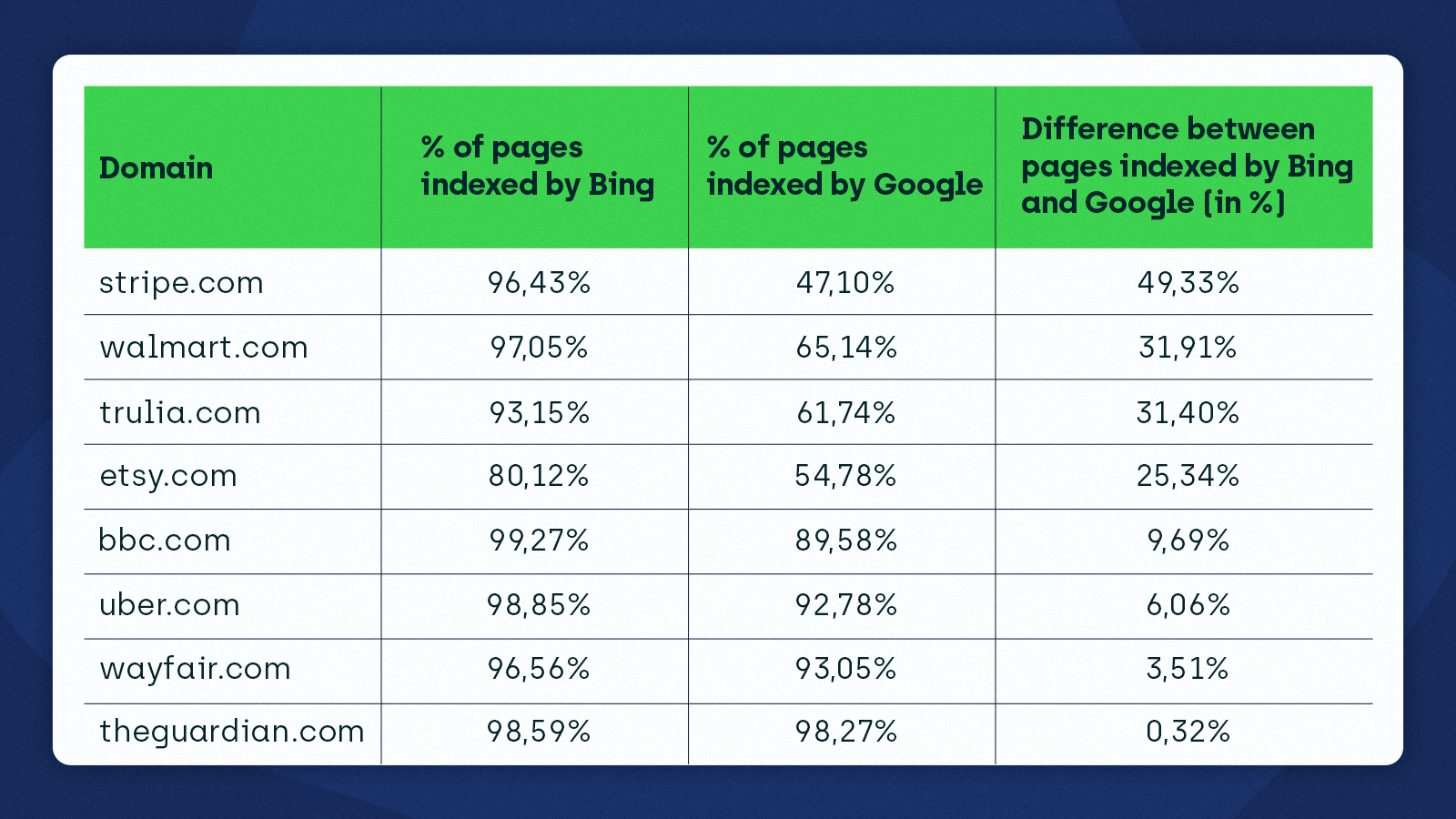

Al treilea aspect al cercetării mele a fost să verific starea de indexare a câtorva site-uri web populare care folosesc ZipTie pentru a vedea cum variază între Bing și Google.

Am aflat că Bing este mult mai dornic să indexeze aceste site-uri decât Google. Acest lucru a confirmat descoperirile mele anterioare pentru eșantionul de site-uri web WordPress care utilizează YoastSEO.

Uită-te la datele pe care le-am primit:

Indexarea Bing vs. Google – observații inițiale

Putem spune că Bing este un motor de căutare mai bun pe baza datelor?

Deși Bing indexează mai mult conținut, nu putem evidenția un singur câștigător doar analizând statisticile de indexare. Nu știm de ce Bing indexează mai mult decât Google.

Ipoteza mea este că Google ar putea fi „mai pretențios” decât Bing. Nu este un mister faptul că selectarea indexului este un lucru.

O spunem de ani de zile – indexarea de către Google devine din ce în ce mai dificilă.

De asemenea, știm că motoarele de căutare accesează cu crawlere paginile la rate diferite.

Iată ce a spus John Mueller despre cât de des Googlebot accesează cu crawlere paginile:

Cred că partea grea aici este că nu accesăm cu crawlere adresele URL cu aceeași frecvență tot timpul. Prin urmare, unele URL-uri le vom accesa cu crawlere zilnic. Unele adrese URL poate săptămânal. Alte adrese URL la fiecare două luni, poate chiar o dată la jumătate de an sau cam asa ceva. Deci, acesta este ceva pentru care încercăm să găsim echilibrul potrivit, astfel încât să nu vă supraîncărcăm serverul. […] Deci, în special, dacă faci lucruri precum interogări pe site, atunci există șansa să vezi acele adrese URL care sunt accesate cu crawlere ca o dată la jumătate de an. Vor fi în continuare acolo după câteva luni. […] dacă credeți că aceste adrese URL chiar nu ar trebui să fie indexate deloc, atunci poate puteți să faceți o copie de rezervă și să spuneți, ei bine, iată un fișier sitemap cu data ultimei modificări, astfel încât Google să se oprească și să încerce să dubleze- verificați-le puțin mai repede decât altfel.sursa: John Mueller

Am găsit și câteva idei interesante în documentația Bing:

Pentru a măsura cât de inteligent este crawler-ul nostru, măsurăm eficiența crawler-ului bingbot. Eficiența accesării cu crawlere este cât de des accesăm cu crawlere și descoperim conținut nou și proaspăt pe pagină accesată cu crawlere. Steaua noastră de eficiență a accesării cu crawlere este să accesăm cu crawlere o adresă URL numai atunci când conținutul a fost adăugat (adresa URL nu a fost accesată cu crawlere înainte), actualizat (context nou pe pagină sau link-uri de ieșire utile). Cu cât accesăm cu crawlere mai mult conținut duplicat, neschimbat, cu atât valoarea noastră privind Eficiența accesării cu crawlere este mai mică.sursa: Seria Bingbot: Maximizing Crawl Efficiency”

Este posibil ca Bing să nu vrea să aprofundeze atunci când accesează cu crawlere site-urile web, deoarece acest lucru ar putea oferi o valoare mică și ar putea duce la scăderea KPI-urilor.

Știm că Bing a lucrat pentru a face crawling mai eficient. De exemplu, Bing a încercat să optimizeze accesarea cu crawlere a conținutului static și să identifice modele care ar reduce frecvența de accesare cu crawlere pe multe site-uri web.

De asemenea, luați în considerare diferențele în modul în care Google și Bing au indexat site-urile WordPress aleatoare – acestea erau mult mai mici. În cazul site-urilor foarte populare, acestea sunt mult mai semnificative.

Acest lucru mă face să cred că, în concordanță cu faptul că Bing admite deschis că utilizează datele despre comportamentul utilizatorilor în algoritmii lor, Bing acordă prioritate indexării site-urilor web care sunt populare, în timp ce pentru Google, popularitatea este un factor mai puțin important.

Vă prezentăm IndexNow

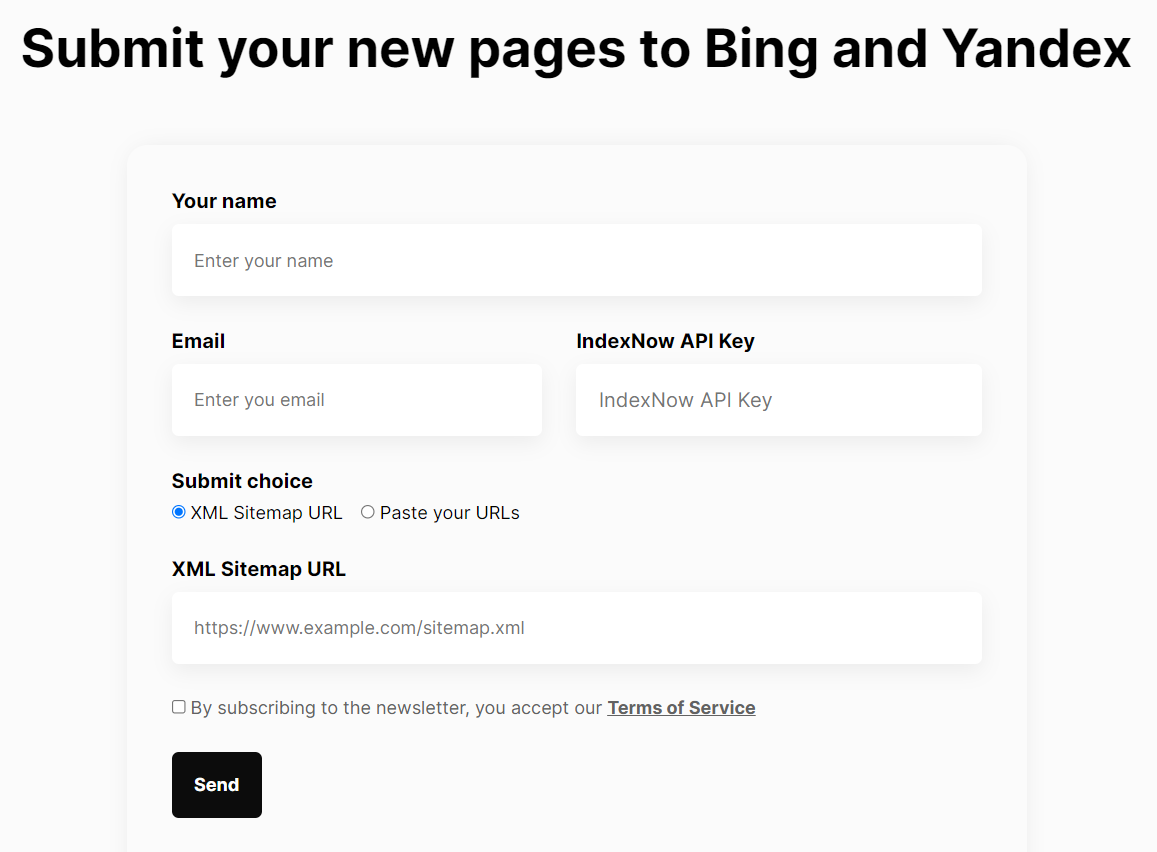

Recent, Bing a făcut un pas mai departe adoptând protocolul IndexNow. Puteți folosi IndexNow pentru a informa Bing și Yandex despre conținut nou sau actualizat.

Prin testele noastre, am aflat că Bing va începe de obicei să acceseze cu crawlere o pagină între 5 secunde și 5 minute de când este trimisă folosind IndexNow.

IndexNow este o inițiativă pentru un Internet mai eficient: spunând motoarelor de căutare dacă o adresă URL a fost schimbată, proprietarii de site-uri web oferă un semnal clar, ajutând motoarele de căutare să acorde prioritate accesării cu crawlere pentru aceste adrese URL, limitând astfel nevoia de accesare cu crawlere exploratorie pentru a testa dacă conținutul are acces cu crawlere. schimbat […].Vom continua să învățăm și să ne îmbunătățim la [o] scară mai mare și vom ajusta ratele de accesare cu crawlere pentru site-urile care implementează IndexNow. Scopul nostru este să oferim fiecărui utilizator beneficiul maxim în ceea ce privește indexarea, gestionarea încărcării cu crawlere și prospețimea conținutului pentru cei care caută.

sursa: Bing Blog, „IndexNow - Indexați instantaneu conținutul dvs. web în motoarele de căutare”

IndexNow permite site-urilor web să își indexeze conținutul mai rapid și să utilizeze mai puține resurse pentru accesare cu crawlere. Drept urmare, companiile pot crea o experiență mai bună pentru clienții lor, oferindu-le acces la cele mai relevante informații.

Am creat un instrument care vă va ajuta să trimiteți adrese URL sau sitemap-uri către IndexNow și mai rapid și mai ușor.

În mod esențial, IndexNow este o oportunitate pentru motoarele de căutare mai mici precum Bing și Yandex să adauge la indexurile lor dintr-o bază de date extinsă de conținut. IndexNow abordează problema cu care motoarele de căutare, inclusiv Google, se confruntă astăzi - trebuie să acceseze cu crawlere și să redeze cantități tot mai mari de conținut.

Timpul va spune dacă Google adoptă protocolul IndexNow sau creează o soluție alternativă care va permite proprietarilor de site-uri să trimită pagini pentru indexare.

Optimizarea modului în care paginile sunt accesate cu crawlere și indexate

O altă concluzie din analiza mea de indexare este cât de importantă este simplificarea accesării cu crawlere și a indexării pentru motoarele de căutare.

În primul rând, trebuie să creați și să mențineți sitemap-uri care să includă adresele URL valoroase. Sitemapurile sunt utile pentru Bing și Google pentru a descoperi conținutul pe care ar trebui să-l indexeze.

Motoarele de căutare se vor strădui să afle ce pagini sunt relevante și ar trebui să fie indexate dacă nu reușiți să trimiteți un sitemap optimizat. Pentru mai multe detalii despre configurarea unui sitemap și ce pagini să includeți, citiți Ghidul nostru final pentru sitemap-urile XML.

În plus, trebuie să aveți un fișier robots.txt care să conțină directive corecte pentru roboți și etichete „noindex” implementate corespunzător pe paginile care nu ar trebui indexate.

Încheierea

Pentru a defini un model clar în indexarea Bing și Google, ar trebui să inspectez mai multe site-uri web, dar există anumite idei pe care le putem obține din mostrele mele de date:

- Bing indexează mai mult conținut decât Google.

- Google descoperă mai mult conținut decât Bing, sugerând că Google este mai pretențios cu indexarea. Principiul călăuzitor pentru Bing este să acceseze cu crawlere mai puțin și să se concentreze pe conținutul care a fost adăugat sau actualizat.

- Bing acordă prioritate indexării site-urilor web populare, în timp ce popularitatea este mai puțin un factor pentru Google.

Putem vedea, de asemenea, că calitatea conținutului și optimizarea accesării cu crawlere și a indexării site-ului dvs. sunt aspecte vitale ale SEO și nu pot fi subestimate sau neglijate. În plus, acești factori vor continua probabil să fie cruciali pe măsură ce web-ul crește și algoritmii motoarelor de căutare devin mai sofisticați.