Ce este SEO tehnic?

Publicat: 2023-09-01Când începi să înveți SEO, vei ajunge în curând să realizezi că există multe fațete diferite pe care trebuie să le înțelegi pentru a reuși.

De la SEO pe pagină la SEO pe pagină și crearea de conținut. Trebuie să ai o înțelegere fermă a tuturor, indiferent de rolul tău specific în cadrul SEO, pentru a obține clasamentul site-ului tău acolo unde trebuie să fie.

În acest articol, vom explora SEO tehnic. Veți afla exact ce este, de ce este important pentru site-uri web și trăsăturile unui site web bine optimizat din punct de vedere tehnic.

Vă vom oferi, de asemenea, informații despre cum funcționează SEO tehnic, de la accesare cu crawlere și indexare la clasare și ce aveți nevoie pentru ca acești trei pași să funcționeze bine împreună.

Credit imagine: https://tsh.io/

Ce este SEO tehnic?

SEO tehnic este procesul de optimizare a elementelor „din culise” ale unui site web pentru a-și îmbunătăți performanța pe motoarele de căutare precum Google și Bing. Acest proces include pași precum îmbunătățirea marcajului și a structurii site-ului web pentru a asigura accesarea cu crawlere, indexarea și clasarea cu ușurință (vom vorbi mai multe despre asta mai târziu) de către roboții motoarelor de căutare precum Googlebot. Sarcinile cuprind rafinarea vitezei site-ului, crearea unei arhitecturi simple și ușor de înțeles, utilizarea URL-urilor „SEO-friendly” și aplicarea de marcare a schemei pentru rezultate de căutare îmbogățite.

În esență, SEO tehnic creează o bază puternică care ajută motoarele de căutare în procesul de ridicare a clasamentului unui site web. Acest lucru va duce în cele din urmă la creșterea traficului organic și la o experiență îmbunătățită a utilizatorului.

Gândiți-vă la site-ul dvs. web ca la o bibliotecă bine organizată. SEO tehnic este pasul de a rafturi ordonat cărțile cu etichete clare (structura dvs. URL), de a crea semne pentru o navigare ușoară (link-urile dvs. interne) și de a crea o ambianță primitoare (viteza site-ului). Când biblioteca este ordonată și primitoare, mai mulți vizitatori pot localiza cărțile de care au nevoie (utilizatorii care descoperă conținut), iar bibliotecarii (roboții motoarelor de căutare) pot clasifica și sugera cărți (indexare și clasare).

De ce este important SEO tehnic?

SEO tehnic este incredibil de important pentru marea majoritate a site-urilor web, deoarece formează baza pentru vizibilitatea și performanța generală a motorului de căutare a site-ului. Desigur, conținutul pe care îl publicați este crucial, dar lipsa unei optimizări tehnice adecvate ar putea împiedica motoarele de căutare să descopere, să indexeze și să clasifice în mod eficient acel conținut.

Semnificația SEO tehnică poate fi rezumată după cum urmează:

În primul rând, se asigură că motoarele de căutare pot accesa cu crawlere și indexează în mod eficient conținutul dvs. Prin optimizarea elementelor precum structura și navigarea site-ului dvs., SEO tehnic facilitează accesarea cu crawlere a site-ului dvs. de către roboții motoarelor de căutare. Această accesibilitate este vitală pentru a vă asigura că conținutul dvs. este observat și indexat corespunzător.

S-ar putea să fim puțin părtinitori, dar credem că site-ul nostru este un exemplu grozav de site care are o arhitectură grozavă!

În al doilea rând, SEO tehnic influențează direct clasamentul în motoarele de căutare. Viteza site-ului și receptivitatea mobilă sunt factori confirmați de clasare în algoritmul de căutare Google și, dincolo de asta, un marcaj HTML bine structurat joacă un rol vital în modul în care motoarele de căutare evaluează calitatea și relevanța site-ului dvs. Un site web bine optimizat are mai multe șanse să se claseze mai sus în motoarele de căutare.

În cele din urmă, SEO tehnic contribuie ca site-ul dvs. să aibă o experiență excelentă pentru utilizator. În timp ce lucrați la SEO tehnic, practici precum optimizarea timpilor de încărcare a paginii și îmbunătățirea adreselor URL vor spori, de asemenea, satisfacția utilizatorilor. O experiență îmbunătățită a utilizatorului duce la rate de respingere reduse și rate de implicare crescute, ceea ce va îmbunătăți indirect performanța site-ului dvs. în căutare.

În cele din urmă, SEO tehnic servește drept piatră de temelie pe care se construiesc strategiile SEO eficiente! Acest lucru garantează că conținutul dvs. nu este doar de top, ci este și descoperit și accesibil. Acest lucru va atrage atât motoarele de căutare, cât și, mai important, utilizatorii.

Care sunt trăsăturile unui site web optimizat tehnic?

Indiferent de site-ul web, fie că este un site de comerț electronic cu venituri de milioane de lire sterline sau un site broșură care prezintă serviciile pentru o companie locală de instalații sanitare, toate site-urile web au aceleași trăsături atunci când vine vorba de a fi bine optimizate din punct de vedere tehnic SEO. .

E rapid

Un site web bine optimizat se va încărca rapid pe toate dispozitivele (desktop, tabletă și mobil) și condițiile rețelei. Paginile cu încărcare rapidă îmbunătățesc experiența pe care o are un utilizator pe site-ul dvs. și sunt favorizate de motoarele de căutare, ceea ce poate duce la poziții mai ridicate.

Știm că Google listează trecerea testelor vitale web de bază ca un factor de clasare confirmat, ceea ce este rar pentru ei, așa că este crucial să vă asigurați că site-ul dvs. este rapid și trece testele CWV.

Este Crawlable

Acest lucru ar trebui să fie o idee simplă, dar site-urile web ar trebui să poată fi accesate cu crawlere de motoarele de căutare. Dacă un bot al motorului de căutare (cum ar fi Googlebot) nu poate accesa cu crawlere site-ul dvs. în mod eficient, veți găsi probleme cu clasarea paginii dvs. pe SERP-uri.

Fișierele Robots.txt și etichetele meta robots ar trebui să fie configurate corect. Acest lucru îi va ajuta pe roboții motoarelor de căutare în ce pagini să acceseze cu crawlere și să indexeze și ce pagini să lase în pace. Nu toate paginile de pe site-ul dvs. ar trebui accesate cu crawlere. În special paginile de administrare și paginile care conțin date despre clienți.

Păstrează capitalul legăturii

Site-urile web care sunt bine optimizate din punct de vedere tehnic fac tot ce le stă în putință pentru a păstra cât mai multă echitate a linkurilor.

În primul rând, site-ul web va folosi link-uri interne care ghidează utilizatorii (și roboții motoarelor de căutare) către conținut relevant din site. Acest lucru îmbunătățește navigarea pe site, ajută la distribuirea link-urilor către alte pagini și menține utilizatorii pe site mai mult timp.

În al doilea rând, site-ul web va fi complet liber (în mod ideal) de legături rupte și lanțuri de redirecționare inutile. Acest lucru asigură o experiență perfectă pentru utilizator și accesare eficientă cu crawlere de către motoarele de căutare.

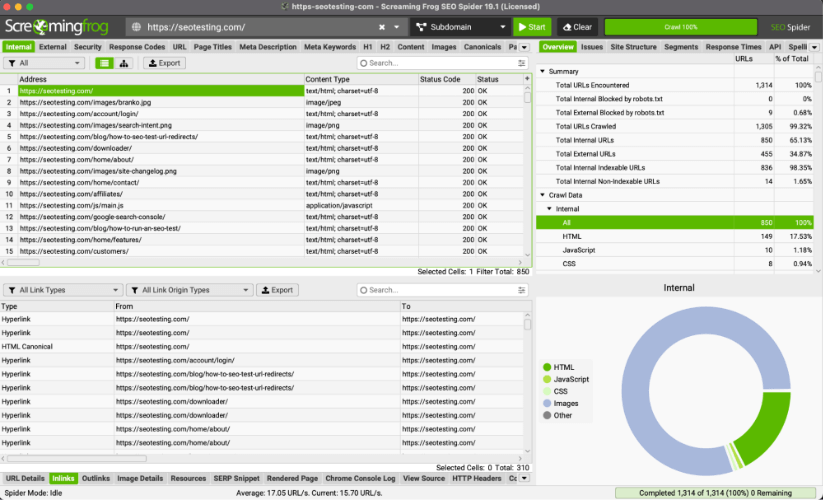

Sfat profesionist: Puteți utiliza ScreamingFrog pentru a identifica legăturile rupte și lanțurile de redirecționare care nu trebuie să fie acolo.

Este compatibil cu dispozitivele mobile

Toate site-urile web ar trebui să fie proiectate pentru a fi receptive și funcționale pe dispozitivele mobile. Odată cu utilizarea din ce în ce mai mare a smartphone-urilor pentru navigare (începând cu 2023, 63% din traficul Google de căutare organică din SUA provine de la dispozitive mobile), compatibilitatea cu dispozitivele mobile este un factor crucial atât în experiența utilizatorului, cât și în clasament.

Este Securizat

Toate site-urile ar trebui să se asigure că site-ul lor utilizează protocolul HTTPS securizat.

Acest lucru face este să vă asigurați că site-ul dvs. are o criptare adecvată a datelor și va spori încrederea pe care o au utilizatorii atunci când vă folosesc site-ul. Această încredere este deosebit de importantă atunci când datele financiare sunt predate pe site-uri web, cum ar fi informațiile despre cardul de credit.

Google a confirmat, de asemenea, că utilizarea protocolului HTTPS este un factor de clasare. Nu știm ce pondere acordă algoritmul, dar putem ghici că acesta este mai mult un factor atunci când avem de-a face cu site-urile YMYL (Your Money Your Life).

Folosește date structurate

Schema de marcare este implementată pe site-uri web pentru a oferi context suplimentar despre conținut. Acest lucru va permite motoarelor de căutare să afișeze fragmente îmbogățite în SERP-urile atunci când vă afișează site-ul web, sporind ratele de clic și aducând mai mult trafic către site-ul dvs.

Crawling

Am tratat acest subiect pe scurt în articolul nostru despre cum să învățați SEO în 2023, dar acum vom trece prin cele patru etape din cadrul SEO tehnic care vă duc site-ul web de la paginile HTML, CSS și JavaScript la clasamente pe SERP. Crawling, randare, indexare și clasare.

Primul pas în această călătorie este târarea.

Crawlingul se referă la procesul prin care motoarele de căutare precum Google și Bing navighează sistematic și învață mai multe despre conținutul site-urilor web de pe internet. Scopul accesării cu crawlere este de a aduna informații despre paginile web, acestea includ:

- Conținutul lor.

- Structura lor.

- Alta informatie relevanta.

Motoarele de căutare pot folosi apoi aceste date pentru a indexa și a clasa în mod eficient (vom vorbi despre asta mai târziu) și pentru a afișa paginile dvs. web în SERP-uri.

Motoarele de căutare folosesc roboți, numiți crawler-uri, pentru a naviga prin numărul imens de pagini web online. Crawlerele încep prin a vizita câteva pagini web binecunoscute, adesea pagini populare sau actualizate frecvent. De acolo, ei urmează linkurile găsite pe aceste pagini pentru a „descoperi” pagini noi pe care apoi le pot reda, indexa și clasa.

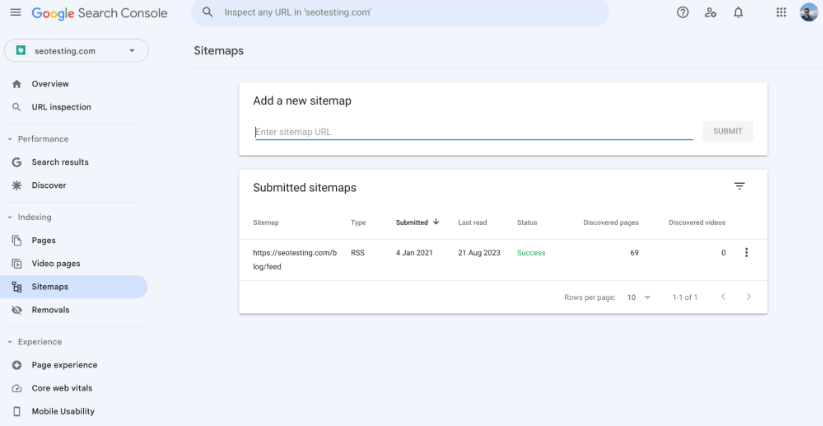

Harta site XML

O hartă de site XML este un fișier care oferă motoarelor de căutare o listă structurată a tuturor adreselor URL de pe site-ul dvs. Este un instrument care îi ajută pe crawlerele motoarelor de căutare să înțeleagă organizarea conținutului site-ului dvs. și se asigură că pot descoperi și indexa în mod eficient toate paginile dvs. importante.

Asigurarea că aveți un sitemap XML pe site-ul dvs. este esențială atunci când vine vorba de SEO tehnic, deoarece vă ajută să accesați cu crawlere paginile în mai multe moduri diferite:

Având o hartă de site XML pe site-ul dvs., oferă roboților motoarelor de căutare o listă centralizată de adrese URL pe care doriți să le acceseze cu crawlere și să le indexeze. Acest lucru vă va ajuta să vă asigurați că toate paginile dvs. esențiale, cum ar fi paginile cu lista de produse și paginile de afișare a produselor, sunt incluse în indexurile motoarelor de căutare și, sperăm, în paginile cu rezultatele motorului de căutare.

De asemenea, puteți utiliza harta site-ului pentru a specifica prioritatea și pentru a modifica frecvența fiecărei adrese URL de pe site-ul dvs. Este important să rețineți că motoarele de căutare s-ar putea să nu respecte aceste reguli exact, dar acest lucru poate oferi crawlerilor o idee despre importanța diferitelor pagini de pe site-ul dvs. și cât de des sunt actualizate.

În timp ce motoarele de căutare folosesc diverși factori pentru a decide ce pagini să acceseze cu crawlere și să indexeze mai întâi, harta site-ului dvs. poate ajuta la evidențierea paginilor importante (sau recent actualizate). Acest lucru poate ghida roboții motoarelor de căutare către aceste pagini și le poate ajuta să le acceseze cu crawlere și să le indexeze rapid. Dacă nu ați avea un sitemap, v-ați baza pe crawler-uri pentru a găsi aceste pagini în mod automat, prin utilizarea de link-uri interne și externe etc. Ceea ce este un proces mult mai lung.

Site-urile mari, cu sute de mii (sau chiar milioane de adrese URL), sitemap-uri (și mai multe sitemap-uri) vor ajuta crawlerii să descopere fiecare pagină pe care doriți să o indexați mai eficient. Acesta este un lucru grozav de făcut, deoarece vă ajută să vă gestionați mult mai eficient bugetul de accesare cu crawlere. Aceasta nu este o problemă pentru site-urile web mai mici, deoarece aceste site-uri mici nu vor avea probleme cu bugetul lor de accesare cu crawlere.

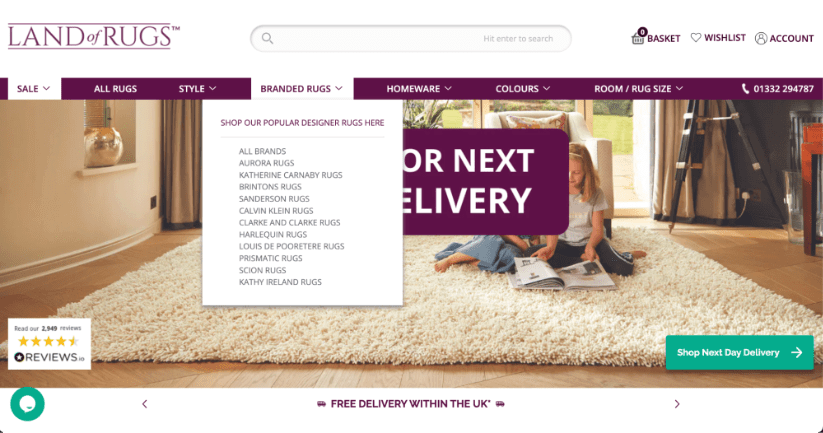

Structura site-ului

Structura site-ului dvs. va juca un rol crucial în determinarea modului în care roboții motoarelor de căutare navighează și indexează conținutul acestuia. O structură bine organizată a site-ului nu numai că va facilita accesarea cu crawlere eficientă de către roboții motoarelor de căutare, dar va îmbunătăți și experiența generală pe care utilizatorii reali o au pe site-ul dvs.

Iată un exemplu de site de comerț electronic cu o structură bună a site-ului. Toate paginile importante (pagini cu lista de produse) din acest exemplu sunt ușor de accesat din bara de navigare a paginii de pornire, transferând cât mai mult posibil link-uri către aceste pagini și asigurându-se că crawlerele le pot găsi cu ușurință.

Atunci când paginile sunt organizate în categorii și subcategorii simple, ușor de înțeles, devine mult mai ușor pentru crawlere să urmărească linkurile și să indexeze conținutul în mod sistematic. Acest aranjament ierarhic asigură că paginile cruciale sunt mai aproape de pagina de pornire, crescând șansele lor de a fi descoperite și indexate rapid.

Legăturile interne din structura unui site web vor ghida mai eficient crawlerele motoarelor de căutare prin diferite secțiuni ale site-ului dvs. Link-urile interne bine plasate și relevante ajută la distribuirea echității link-urilor între pagini, permițând crawlerilor să descopere o gamă mult mai largă de conținut decât ar putea fără link-uri interne plasate în conținutul dvs.

Paginile orfane (pagini fără linkuri care să indice către ele) ar trebui evitate, deoarece reprezintă o provocare uriașă pentru crawler-uri. O structură robustă a site-ului, cu legături interne adecvate, evită acest lucru.

În general, structura site-ului dvs. va servi ca un cadru crucial care modelează modul în care motoarele de căutare vă accesează cu crawlere și indexează conținutul. Prin implementarea unei ierarhii clare a site-urilor, adăugarea de link-uri contextuale relevante și optimizarea pentru alocarea bugetului de accesare cu crawlere (dacă este necesar), proprietarii de site-uri web și agenții de marketing pot influența pozitiv modul în care motoarele de căutare își accesează cu crawlere site-urile web.

Structura URL

Structura URL a site-ului dvs. va avea un impact direct asupra accesării cu crawlere a site-ului dvs. web. Asigurarea că aveți o structură URL bine organizată (și descriptivă) va spori eficiența crawlerelor în înțelegerea conținutului fiecărei pagini. Adresele URL clare (și scurte) oferă un context valoros despre subiectul și ierarhia locației paginii pe site.

De exemplu, o adresă URL care arată astfel: https://example.com/blog/head-topic-1 va spune unui motor de căutare crawler că această pagină este o pagină esențială a blogului, despre unul dintre subiectele cheie ale site-ului.

Pe de altă parte, adresele URL care sunt complicate sau fără sens (un exemplu bun este https://example.com/12642/test-category/test-page125253/) pot încurca crawlerele atunci când navighează pe site-ul dvs. web. Acest lucru va împiedica capacitatea acestora de a interpreta conținutul, precum și relevanța și importanța paginii din site-ul dvs. O structură URL curată, fără parametri și simboluri inutile, va crește șansele ca paginile dvs. să fie accesate cu crawlere în mod eficient.

În plus, deși nu are legătură directă cu accesarea cu crawlere, structura URL-ului dvs. va avea un impact direct asupra experienței utilizatorului site-ului dvs. și asupra ratelor de clic. O adresă URL concisă și relevantă este mult, mult mai probabil să atragă clicuri ale utilizatorilor în rezultatele căutării, ceea ce poate afecta (indirect) clasamentul general al site-ului dvs. în motorul de căutare.

Fișierele Robots.txt

Fișierul dvs. robots.txt deține o putere enormă asupra modului în care motoarele de căutare navighează și accesează cu crawlere site-ul dvs. Acest document, situat în centrul site-ului dvs., detaliază instrucțiuni pentru crawlerele motoarelor de căutare, dictând cum ar trebui să fie accesat cu crawlere site-ul dvs. Inclusiv ce pagini pot fi accesate cu crawlere și ce pagini ar trebui lăsate în pace.

Merită remarcat în această etapă că, deși fișierul dvs. robots.txt poate opri intrarea crawlerelor în anumite pagini sau secțiuni ale site-ului dvs. web, acesta nu garantează că paginile dvs. nu vor fi accesate cu crawlere pe căi alternative. Unele motoare de căutare pot înregistra în continuare pagini care sunt excluse de la accesare cu crawlere dacă sunt găsite prin alte moduri, de exemplu, prin link-uri interne pe site-ul dvs.

Dacă fișierul dvs. robots.txt este plin de erori sau reguli rigide, este posibil să observați că acest lucru împiedică motoarele de căutare să acceseze cu crawlere conținut important, care poate „aruncă o umbră” asupra performanței site-ului dvs. în SERP-uri. Este important să urmăriți în mod regulat fișierul robots.txt pentru a vă asigura că toate regulile funcționează corect.

Analiza fișierului jurnal

Analizarea fișierelor jurnal ale site-ului dvs. poate avea un impact imens asupra modului în care motoarele de căutare vă accesează site-ul cu crawlere, iar acest lucru este ceva pe care specialiștii în marketing îl pot face singuri cu instrumentele potrivite! Fișierele jurnal sunt, în esență, înregistrări care arată ce părți ale site-ului dvs. accesează motoarele de căutare și cât de des accesează crawlerele motoarelor de căutare aceste părți ale site-ului dvs. În esență, acest lucru vă permite să determinați care pagini de pe site-ul dvs. sunt considerate importante de motoarele de căutare, permițându-vă să utilizați acest lucru pentru a obține un avantaj.

Acest lucru îi ajută pe specialiști în marketing să decidă pe care pagini merită să aloce mai mult timp (și potențial bani), asigurându-se că motoarele de căutare acordă atenție lucrurilor potrivite. De asemenea, analiza fișierelor jurnal poate arăta dacă motoarele de căutare găsesc site-ul dvs. ușor de înțeles și de navigat sau dacă au probleme. Acest lucru poate ghida modificări, cum ar fi remedierea modului în care sunt conectate paginile (prin linkuri interne, în general) sau organizarea mai bună a adreselor web.

Una dintre discuțiile mele preferate despre asta este de la Matthew Barby, din 2018, când era vicepreședinte al creșterii organice la HubSpot, găsiți segmentul exact al discuției la 25:07:

Redare

Redarea se referă la procesul prin care motoarele de căutare analizează și înțeleg conținutul și structura site-ului dvs., pentru a determina clasarea acestuia pe SERP-uri. Acest proces presupune doi pași principali, crawling (pe care am tratat-o) și indexare (despre care vom vorbi în curând).

În timpul accesării cu crawlere, roboții motoarelor de căutare traversează web, vizitând pagini web și colectând date HTML. Cu toate acestea, nu tot conținutul este vizibil imediat în marcajul HTML. Aici intervine randarea.

Redarea depășește analiza HTML de bază, ținând cont de elementele dinamice adesea prezentate pe site-urile web moderne care ar putea să nu fie vizibile în HTML brut. Aceasta include conținut încărcat prin JavaScript, AJAX sau alte limbaje de scripting, precum și foaia de stil CSS a paginii. Boții motoarelor de căutare, în încercarea lor de a simula experiența utilizatorului, execută JavaScript și adună conținutul redat complet/ Acest conținut este apoi folosit pentru a construi un index, o bază de date de informații despre pagina web.

Pentru rezultate optime SEO, este esențial să vă asigurați că site-ul dvs. este ușor de redat de către roboții motoarelor de căutare. Acest lucru implică utilizarea unor tehnici precum randarea pe server (SSR) sau pre-rendarea pentru site-urile web cu JavaScript. Furnizarea de metadate (cum ar fi meta-etichete și descrieri) va ajuta motoarele de căutare să înțeleagă contextul și sensul conținutului. Gestionarea corectă a etichetelor canonice și gestionarea redirecționărilor este, de asemenea, importantă pentru a preveni problemele de conținut duplicat.

Indexarea

Indexarea se referă la procesul de colectare, organizare și stocare a informațiilor despre paginile web, astfel încât acestea să poată fi preluate rapid și afișate în rezultatele căutării atunci când un utilizator caută o interogare relevantă. Odată ce un crawler web a accesat cu crawlere o pagină web și a redat conținutul acesteia, informațiile sunt adăugate la indexul motorului de căutare.

Indexul, în esență, este o bază de date uriașă care conține informații despre conținutul site-ului web și structura paginilor web de pe internet. Având acces la această vastă bază de date de informații, motoarele de căutare pot răspunde rapid la întrebările utilizatorilor, găsind pagini relevante din index și afișându-le în SERP-uri.

În timpul procesului de indexare, motoarele de căutare extrag informații cheie din paginile web accesate cu crawlere și redate, cum ar fi conținut, metadate, imagini și link-uri. Aceste informații sunt apoi stocate într-un mod structurat, ceea ce permite motoarelor de căutare să potrivească rapid interogările utilizatorilor cu paginile relevante.

Există câteva lucruri pe care ar trebui să cauți să le faci, pentru a ajuta la indexarea eficientă a paginilor.

Rezolvați problemele legate de conținutul duplicat și canibalizarea cuvintelor cheie

Abordarea conținutului duplicat și a problemelor de canibalizare a cuvintelor cheie va oferi beneficii semnificative atunci când vine vorba de indexarea rapidă a paginilor.

Scăpând conținutul duplicat, preveniți orice confuzie pentru motoarele de căutare, permițându-vă să identificați cu exactitate versiunea principală a conținutului dvs.

În plus, rezolvarea problemelor de canibalizare a cuvintelor cheie - în cazul în care mai multe pagini vizează aceleași cuvinte cheie - oferă motoarelor de căutare semnale clare despre focalizarea fiecărei pagini. Această claritate ajută la indexarea și clasarea eficientă, deoarece motoarele de căutare pot înțelege scopul exact al tuturor paginilor dvs.

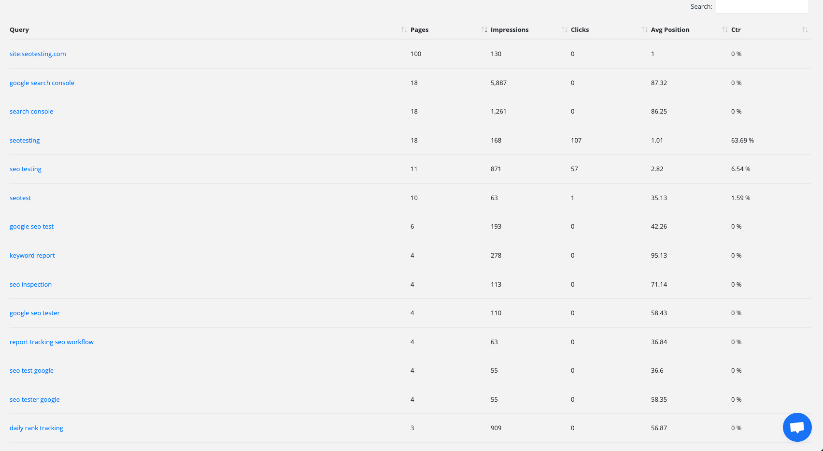

O imagine care arată Raportul de canibalizare a cuvintelor cheie în cadrul SEOTesting. Acest raport vă poate ajuta să identificați și să remediați rapid orice probleme legate de canibalizarea cuvintelor cheie de pe site-ul dvs.

Optimizarea metadatelor (cum ar fi etichetele de titlu și meta descrierile) precum și ajustarea structurilor de legături interne vor contribui, de asemenea, la o indexare rapidă și ușoară. Aceste acțiuni, atunci când sunt făcute corect, ghidează motoarele de căutare către cele mai relevante și importante pagini.

În plus, consolidarea conținutului și evitarea canibalizării cuvintelor cheie va concentra autoritatea conținutului dvs. pe o singură pagină. Acest lucru va duce la o mai mare autoritate a paginii, încurajând motoarele de căutare să prioritizeze și să clasifice acea pagină cu autoritate mai proeminent în SERP-uri.

Redirecționări de audit

Examinarea modului în care funcționează redirecționările site-ului dvs. poate ajuta la îmbunătățirea rapidității cu care motoarele de căutare vă indexează conținutul. De asemenea, poate ajuta la îmbunătățirea performanței generale a site-ului dvs. web. Redirecționările acționează ca niște piețe, ghidând atât utilizatorii, cât și motoarele de căutare către diferite pagini atunci când este necesar. Dacă nu sunt gestionate bine, acestea pot încetini procesul de indexare sau pot împiedica complet indexarea paginilor. Efectuând un „audit de redirecționare”, puteți îmbunătăți indexarea în mai multe moduri semnificative.

În primul rând, abordarea redirecționărilor excesive va ajuta motoarele de căutare să funcționeze mai eficient atunci când indexează site-ul dvs. Uneori, aceștia pot întâlni mai multe redirecționări, ceea ce le poate încetini indexarea conținutului dvs. Găsind și eliminând redirecționări inutile, puteți ajuta motoarele de căutare să vă acceseze rapid conținutul, oferindu-le o șansă mai bună de a fi indexați (și, prin urmare, clasați) rapid.

Finalizarea unui audit de redirecționare vă va permite, de asemenea, să abordați o problemă tehnică comună SEO. Lanțuri de redirecționare. Astfel de lanțuri se pot întâmpla atunci când o redirecționare duce la alta, care duce la alta, care duce la alta și așa mai departe. Ele pot încurca motoarele de căutare și pot consuma prea mult din timpul lor. Știm că atunci când un robot de căutare durează prea mult timp încercând să indexeze o pagină, va merge mai departe și nu va indexa pagina respectivă. Un audit vă va permite să găsiți și să remediați aceste lanțuri, permițând motoarelor de căutare să vă acceseze conținutul fără probleme.

În cele din urmă, un audit ca acesta va ajuta motoarele de căutare să înțeleagă cu exactitate site-ul dvs. Când redirecționările sunt bine structurate, motoarele de căutare pot interpreta mai bine importanța conținutului dvs. Când motoarele de căutare vă înțeleg mai bine importanța conținutului, paginile dvs. importante au șanse mai mari de a fi indexate rapid.

Remediați erorile HTTP și HTTPS

Remedierea erorilor HTTP și HTTPS este vitală pentru a vă asigura că paginile dvs. sunt indexate corect. Când roboții motoarelor de căutare întâmpină aceste tipuri de erori, le este greu să acceseze și să înțeleagă conținutul dvs. Când un robot robot de motor de căutare nu poate accesa sau înțelege conținutul dvs., nu îl poate indexa.

Abordarea acestor probleme îmbunătățește indexarea în următoarele moduri:

În primul rând, rezolvarea erorilor HTTP precum „404 Not Found” asigură că paginile dvs. sunt accesibile atât utilizatorilor, cât și motoarelor de căutare. Când paginile returnează aceste erori, motoarele de căutare le vor interpreta drept conținut lipsă, ceea ce duce la excluderea din rezultatele căutării. Remedierea acestor erori oferă crawlerilor o „cale clară” pentru a vă indexa conținutul, crescând șansele de a le indexa și de a le clasa.

În al doilea rând, trecerea de la HTTP la HTTPS este crucială pentru securitate și indexare. Motoarele de căutare acordă prioritate majoră site-urilor web securizate (HTTPS) față de site-urile web nesecurizate (HTTP) în algoritmii lor de clasare. Google chiar a confirmat acest lucru! Migrând la HTTPS și asigurând o experiență de navigare sigură pentru utilizatori, sporiți credibilitatea site-ului dvs., îmbunătățind indirect capacitatea acestuia de a fi indexat și clasat.

În cele din urmă, implementarea consecventă a HTTPS și rezolvarea erorilor legate de HTTPS împiedică utilizatorii și motoarele de căutare să întâmpine probleme de „conținut mixt”. Conținutul mixt apare atunci când elementele sigure și nesecurizate sunt încărcate pe aceeași pagină. Acest lucru ar putea cauza avertismente de securitate și poate avea un impact negativ asupra experienței utilizatorului.

În esență, abordarea erorilor HTTP și HTTPS elimină barierele care împiedică motoarele de căutare să acceseze și să înțeleagă conținutul dvs. Această abordare extrem de proactivă optimizează procesul de indexare, crește vizibilitatea în rezultatele căutării și îmbunătățește experiența utilizatorului pe site-ul dvs.

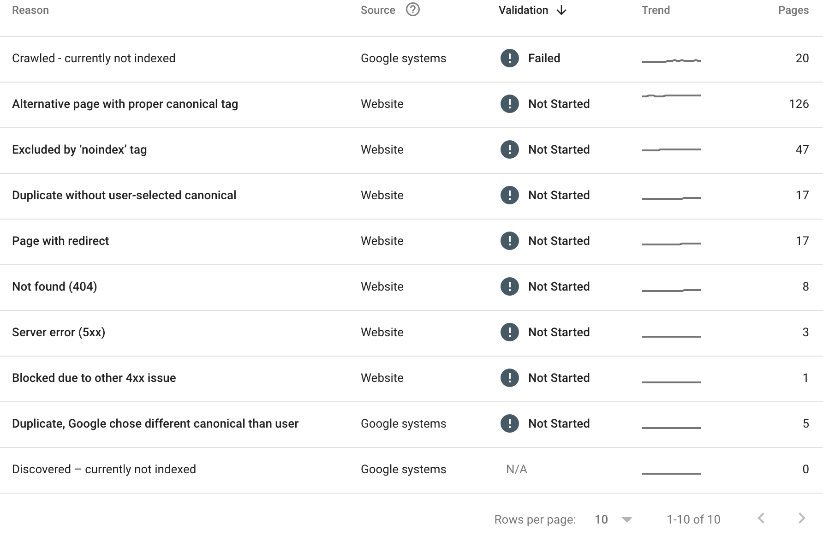

Consultați „Raportul de indexare a paginilor” din Google Search Console

Google Search Console este o mină de aur pentru a evalua modul în care conținutul dvs. este indexat. În raportul dvs. de indexare a paginii, veți putea vedea fiecare pagină de pe site-ul dvs. care nu a fost indexată. De asemenea, veți putea vedea motivul pentru care pagina nu a fost indexată.

Iată un exemplu:

În cele de mai sus (raportul de indexare a paginii SEOTesting), putem vedea că:

- 20 de pagini au fost accesate cu crawlere, dar nu sunt indexate în prezent.

- 126 de pagini au o etichetă canonică adecvată.

- 47 de pagini au fost excluse de eticheta „noindex”.

- S-a constatat că 17 pagini au fost duplicate, fără niciun canonic selectat de utilizator.

- 17 pagini au o redirecționare.

- 8 pagini au returnat o eroare 404.

- 3 pagini au returnat o eroare de server 5xx.

- 1 pagină a fost blocată din cauza unei alte probleme 4xx.

- 5 pagini au fost găsite ca duplicate, iar Google a ales un alt canonic.

Nu toate motivele de mai sus sunt probleme, dar merită ca noi, ca echipă de marketing, să aflăm de ce anumite pagini nu au fost indexate și să remediem cât mai multe dintre aceste probleme.

Clasament

Clasamentul motoarelor de căutare este punctul culminant al proceselor de crawling, randare și indexare, în care motoarele de căutare determină ordinea în care apar paginile web în SERP-uri. Scopul este de a prezenta utilizatorilor cel mai relevant și valoros conținut, pe baza interogărilor lor de căutare.

În esență, clasamentul se bazează pe algoritmi complecși care evaluează o varietate de factori pentru a determina relevanța și autoritatea unei pagini web. Unul dintre aspectele fundamentale este relevanța cuvintelor cheie - cât de bine se potrivește conținutul cu cuvintele și expresiile introduse de utilizatori în căutările lor. Paginile cu relevanță mare a cuvintelor cheie tind să se claseze mai bine.

Cu toate acestea, relevanța cuvintelor cheie nu este suficientă. Motoarele de căutare iau în considerare și calitatea și autoritatea site-ului web. Backlink-urile de la site-uri reputate, autorizate și relevante (acest lucru este crucial), sunt un indicator puternic al credibilității unei pagini. Cu cât o pagină are mai multe backlink-uri de înaltă calitate, cu atât este mai probabil să se claseze mai sus.

Experiența pe care utilizatorii o au pe site-ul dvs. web joacă, de asemenea, un rol important în clasament. Paginile care se încarcă rapid, sunt prietenoase cu dispozitivele mobile și oferă o experiență de navigare fluidă pentru utilizator sunt foarte favorizate de motoarele de căutare. Conținut atractiv și valoros, care îi ține pe utilizatorii pe site-ul dvs., să navigheze, mai mult timp, semnalează și motoarele de căutare că site-ul dvs. ar putea merita să fie clasat mai sus.

Personalizarea este un alt aspect al clasamentului. Motoarele de căutare vor ține cont de locația utilizatorului, istoricul căutărilor și preferințele pentru a personaliza rezultatele căutării, pentru a oferi utilizatorului cea mai bună experiență posibilă. Aceasta înseamnă că aceeași interogare va produce, cel mai probabil, rezultate diferite pentru utilizatori diferiți.

Este important să ne amintim că, indiferent de ce menționează alte postări de blog, nu știm ce pondere acordă Google (și alte motoare de căutare) diferiților factori pentru diferite interogări. Pentru o întrebare, poate fi necesar să vă bazați mai mult pe backlink-uri autorizate și relevante. Pentru altul, poate fi necesar să vă asigurați că experiența dvs. de utilizator este perfectă. Toate acestea se rezumă la timp în industrie, învățând algoritmul și îmbunătățindu-vă pe măsură ce mergeți.

Înțelegerea diferitelor aspecte SEO este vitală pentru succesul în SERP-uri. Acest articol a explorat importanța SEO tehnică, trăsăturile site-urilor optimizate și mecanica SEO tehnică de la accesare cu crawlere la clasare.

SEO tehnic construiește o bază puternică pentru site-ul dvs., optimizând elemente pentru o viteză și o structură mai bune. Acest lucru îmbunătățește navigarea, înțelegerea conținutului și experiența utilizatorului.

Pe scurt, SEO tehnic este cheia. Prin remedierea erorilor și optimizarea structurii site-ului, vă veți putea îmbunătăți prezența online.

Doriți să vă îmbunătățiți utilizarea Google Search Console și să vă duceți SEO la următorul nivel prin implementarea testării SEO în rutina dvs.? Încercați SEOTesting. În prezent, derulăm o perioadă de încercare gratuită de 14 zile, fără card de credit necesar pentru a vă înscrie. Încercați instrumentul astăzi și spuneți-ne ce părere aveți!