Jakiej technologii używają wyszukiwarki do indeksowania stron internetowych?

Opublikowany: 2023-03-02

Jeśli kiedykolwiek zastanawiałeś się, jakiej technologii wyszukiwarki używają do indeksowania stron internetowych, przygotuj się na odpowiedź na swoje pytania. Dowiesz się, czym jest robot indeksujący, jakie są różne typy robotów indeksujących używanych przez główne wyszukiwarki i na czym polega proces indeksowania wyszukiwania. Dowiesz się również, jak to wszystko wpłynie na wyniki wyszukiwania i jak właściciele witryn mogą nakazać robotom indeksującym wyszukiwarki indeksowanie treści zgodnie z ich życzeniami. Dowiedzmy się więcej o tej technologii, z której korzystają wyszukiwarki, aby dokładnie dostarczać miliardy trafnych wyników wyszukiwania osobom, które szukają informacji w sieci WWW.

Co to są roboty indeksujące lub boty wyszukiwarek?

Roboty indeksujące, znane również jako pająki, to zautomatyzowane programy, których firmy takie jak Google i Microsoft używają do uczenia swoich wyszukiwarek, co jest obecne na każdej dostępnej stronie internetowej każdej witryny internetowej, którą mogą znaleźć w Internecie. Tylko poprzez poznanie, jakie informacje są zawarte na stronie internetowej, te wyszukiwarki mogą dokładnie pobrać te informacje, gdy jeden z ich użytkowników wpisze zapytanie, prosząc o informacje na określony temat.

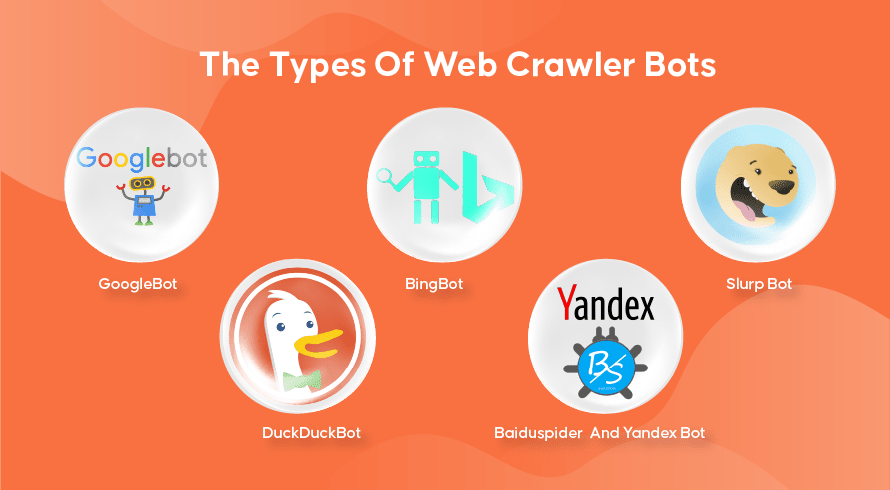

Rodzaje robotów indeksujących sieć

Każda wyszukiwarka ma swoje roboty indeksujące. Oto niektóre z najczęściej używanych.

GoogleBot

Google jest najpopularniejszą wyszukiwarką na świecie i używa dwóch wersji robotów indeksujących do indeksowania setek miliardów stron internetowych. GoogleBot Desktop będzie przeglądał strony naśladujące zachowanie osoby korzystającej z komputera stacjonarnego do przeglądania internetu, podczas gdy GoogleBot Mobile zrobi to samo z użytkownikami smartfonów.

GoogleBot to jeden z najskuteczniejszych rodzajów botów wyszukiwania, jakie kiedykolwiek stworzono, i może szybko przeszukiwać i indeksować strony internetowe. Ma jednak pewne problemy z indeksowaniem bardzo złożonych struktur witryn. Ponadto indeksowanie nowo opublikowanej strony internetowej może zająć GoogleBotowi wiele dni lub tygodni, co oznacza, że przez jakiś czas nie będzie ona wyświetlana w trafnych wynikach.

Bingbot

Bingbot to odpowiedź Microsoftu na Google w ich własnej wyszukiwarce Bing. Działa to podobnie do robota indeksującego Google, a nawet zawiera narzędzie do pobierania, które wskazuje, w jaki sposób bot będzie indeksować stronę, co pozwala sprawdzić, czy występują tutaj jakieś problemy.

Siorbany Bot

Slurp Bot to robot indeksujący używany przez Yahoo, chociaż używa on również Bingbota do dostarczania wyników wyszukiwania. Właściciel witryny musi zezwolić Slurp Bot na dostęp, jeśli chce, aby zawartość jego strony internetowej pojawiała się w wynikach wyszukiwania Yahoo Mobile. Co więcej, Slurp Bot może również uzyskiwać dostęp do witryn partnerskich Yahoo w celu dodawania treści do ich witryn Yahoo News, Yahoo Sports i Yahoo Finance.

KaczkaDuckBot

Jest to robot sieciowy używany przez DuckDuckGo, wyszukiwarkę znaną z zapewniania użytkownikom niezrównanego poziomu prywatności, ponieważ nie śledzi ich aktywności, jak robi to wiele popularnych wyszukiwarek. Dostarczają wyniki wyszukiwania uzyskane z ich DuckDuckBot, a także stron społecznościowych, takich jak Wikipedia i inne wyszukiwarki.

Baiduspider i bot Yandex

Są to roboty indeksujące używane odpowiednio przez wyszukiwarki Baidu z Chin i Yandex z Rosji. Baidu ma ponad 80% udziału w rynku wyszukiwarek w Chinach kontynentalnych.

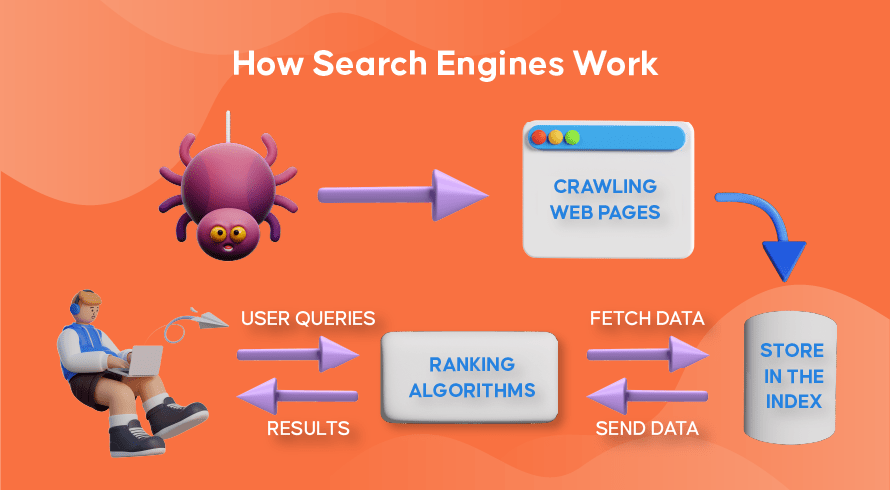

Jak działa indeksowanie sieci, indeksowanie wyszukiwania i ranking w wyszukiwarkach

Przyjrzyjmy się teraz, w jaki sposób większość wyszukiwarek używa robotów indeksujących do znajdowania, przechowywania, organizowania i pobierania informacji zawartych w witrynach internetowych.

Jak działają roboty indeksujące

Proces znajdowania zarówno nowych, jak i zaktualizowanych treści na stronach internetowych nazywa się „przeszukiwaniem sieci”, stąd nazwa programów realizujących tę funkcję. Boty najpierw zaczną indeksować kilka stron internetowych, znajdą ich zawartość, a następnie podążą za hiperłączami zawartymi na tej stronie internetowej, aby odkryć nowe adresy URL, prowadzące do jeszcze większej ilości treści.

Jak działa indeksowanie w wyszukiwarkach

Po tym, jak boty odkryją nową lub zaktualizowaną treść poprzez indeksowanie sieci, wszystko, co znajdą, jest dodawane do ogromnej bazy danych zwanej „indeksem wyszukiwarki”. To jest jak biblioteka, w której książki są jak strony internetowe, zorganizowane w celu późniejszego łatwego wyszukiwania. Zawierają w każdej książce większość tekstu zawartego na stronie internetowej, którą możemy zobaczyć (z wyjątkiem słów takich jak „a”, „an” i „the”), a także metadane, które widzą tylko roboty. Metadane to coś, czego wyszukiwarki używają do zrozumienia zawartości strony internetowej. Tytuł meta i opis meta to przykłady metadanych.

Jak działa ranking wyszukiwania

Za każdym razem, gdy użytkownik wpisze zapytanie, odpowiednia wyszukiwarka sprawdzi jego indeks, znajdzie najistotniejsze informacje pasujące do tego żądania, uporządkuje listę linków internetowych zawierających odpowiednią treść i przedstawi ją użytkownikowi w wyszukiwarce strony wyników (SERP).

Ta organizacja SERP nazywa się „rankingiem wyszukiwania” i jest wykonywana przez algorytm wyszukiwania, który bierze pod uwagę zebrane dane, w tym metadane, wiarygodność strony internetowej (autorytet), a także słowa kluczowe i linki. Witryny, które są uważane za bardzo wiarygodne źródła i zawierają bardzo trafne treści, które będą przydatne dla użytkowników, będą wysoko w rankingu, uzyskując najlepsze wyniki w SERP. Dlatego każdy właściciel witryny ma strategie pozycjonowania swojej witryny w SERP.

Jak optymalizacja wyszukiwarek (SEO) wchodzi w grę

Właściciele witryn mogą optymalizować treści na swoich stronach w taki sposób, aby wyszukiwarki łatwiej rozpoznawały je jako istotne i przydatne dla ich użytkowników. Spowoduje to przesunięcie tych stron na szczyt SERP, przynosząc więcej ruchu organicznego do witryny. Strategiczne włączenie odpowiednich słów kluczowych do tekstu strony, budowanie linków oraz wykorzystanie oryginalnych obrazów i filmów to tylko niektóre ze sposobów wykorzystania technik SEO.

Ponadto strony internetowe mogą również korzystać z różnych narzędzi, takich jak SEMrush, aby znajdować i naprawiać różne problemy na swoich stronach, takie jak zepsute linki, co jeszcze bardziej poprawi ich ranking w oczach wyszukiwarek.

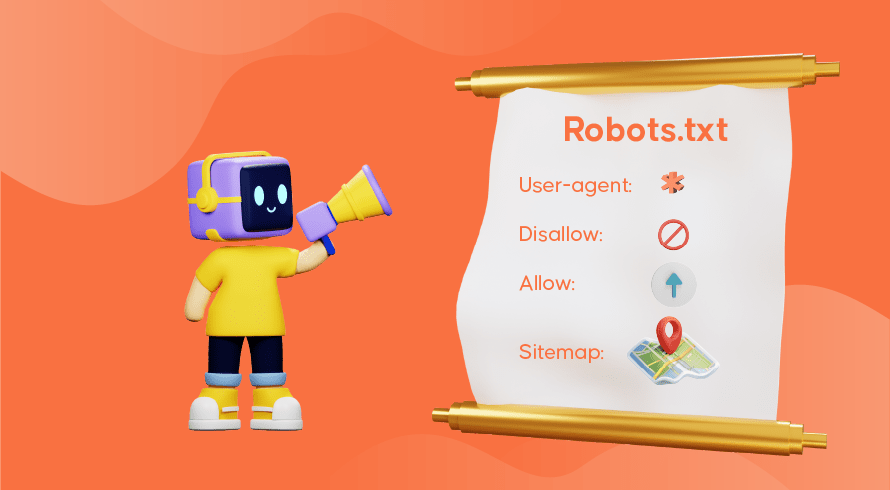

Informowanie wyszukiwarek, jak zaindeksować Twoją witrynę

Czasami okaże się, że roboty indeksujące nie spełniły odpowiednio swojej funkcji, przez co w indeksie brakuje ważnych stron Twojej witryny. Oznacza to, że trafne zapytania wyszukiwania nie będą wyświetlane wraz z Twoimi treściami, co utrudnia potencjalnym klientom znalezienie drogi do Twoich stron. Na szczęście istnieją sposoby komunikowania się z wyszukiwarkami, które pozwalają na pewną kontrolę nad tym, co jest indeksowane, a co ignorowane.

Plik robots.txt przechowywany w katalogu głównym Twojej witryny informuje roboty indeksujące, które strony mają być indeksowane, które mają być ignorowane i jak zorganizowana jest architektura Twojej witryny. Możesz chcieć uniemożliwić indeksowanie określonych stron, jeśli są one używane do testowania lub specjalnych promocji i zduplikowanych adresów URL używanych w handlu elektronicznym.

Na przykład GoogleBot będzie kontynuował pełne indeksowanie witryny, jeśli nie ma pliku robots.txt. Po wykryciu pliku robots.txt GoogleBot będzie postępował zgodnie z instrukcjami podczas indeksowania. Jeśli ma problem z wykryciem pliku lub napotka błąd, może nie zaindeksować Twojej witryny. Musisz poprawnie używać pliku robots.txt, organizować architekturę witryny i stosować najlepsze praktyki SEO na stronie, aby uniknąć problemów z indeksowaniem. Możesz przeprowadzić audyt witryny, aby przeanalizować i zidentyfikować wszelkie problemy, które nękają Twoją witrynę.

Potrzebujesz usług SEO dla swojej witryny?

Jeśli szukasz dostawcy usług, który rozumie, jak działają roboty indeksujące i indeksowanie wyszukiwania, aby poprawić rankingi Twojej witryny, Inquivix jest partnerem SEO, którego szukałeś. Zapewniamy kompleksowy zestaw usług SEO na stronie, od tworzenia treści, po optymalizację architektury witryny i analizę wydajności witryny, aby stale poprawiać jakość korzystania z witryny. Aby dowiedzieć się więcej, odwiedź stronę Usługi SEO na stronie Inquivix już dziś!

Często zadawane pytania

Wyszukiwarki używają programów zwanych „przeszukiwaczami sieci”, znanymi również jako „pająki” lub „boty”, aby odkrywać zarówno nowe, jak i zaktualizowane treści na stronach witryny. Następnie podąży za linkami zawartymi na stronie, aby znaleźć więcej stron. Treść znaleziona na stronie jest zapisywana w indeksie, który służy do pobierania informacji do wyników wyszukiwania, gdy użytkownik o to poprosi.

GoogleBot Desktop i GoogleBot Mobile to najpopularniejsze roboty indeksujące w większości krajów, a następnie Bingbot, Slurp Bot i DuckDuckBot. Baiduspider jest używany głównie w Chinach, podczas gdy Yandex Bot jest używany w Rosji.